Протоколы передачи данных «внутре». Для тех, кто забыл базу

Для лиги лени: заголовок некорректный, в остальном ничего нового за 2020-2025 не появилось.

Вроде, 2025 год заканчивается, а люди до сих пор пишут то про классовое общество адресацию в TCP\IP .

АУ! Ну вы и сони. Даже ipv6 шторм вас не разбудил.

VLSM (variable-length subnet masking ) и CIDR (Classless Inter-Domain Routing) появились в 1993 году. Вы, любители рассказать про классы, откуда разморозились, из запасов сайта новостей Минцифры и тамошних комментариев про поддержку импортозамещения? Именно там регулярно всплывают такие размороженные персонажи – последний раз были на сайте в 1998 году, и вдруг решили рассказать, что раньше жили в грехе, а теперь открыли для себя KVM и третий глаз, и теперь только классы, только хардкор.

Другие .. комментаторы записывают iSCSI в устаревшие. Что тоже удивительно.

Теперь, удивившись, перейду к теме.

Сетевые протоколы передачи данных, и вот это все.

Примечание. Беспроводные протоколы, начиная от 4G-5G, и до 6G и Zigbee, в рассмотрение не попадают. Как и протоколы “передачи слова «нейтрино» азбукой Морзе по потоку нейтрино»”.

На почти самом низу (почти) живут три больших семейства протоколов.

Первый, и самый большой, это все семейство Ethernet. Начиная с до сих пор встречающегося по домам Ethernet 100 мбит (а то и 10, для умных счетчиков), и заканчивая Ethernet 800G. К июлю 2026 обещают стандарт 1600G - 802.3dj.

Примечание для любителей импортозамещения. 100G коммутаторы только-только заявлены у Ядро, и, может быть, через пару лет будут у Eltex – когда китайские производители будут массово производить 100G чипы. Или, можете вместе Mellanox (хотя бы SN2700) импортозаместиться на Huawei CloudEngine 8800. Если денег хватит.

Чтобы было понятнее, речь идет о покупке Mellanox SN2700-CS2F 100GbE 100G Ethernet Switch 32 QSFP28 Ports. На ебей такой стоит $3300. В РФ привезут за месяц, и тысяч за 300 рублей.

Второй, все умирающий, но никак не могущий умереть, это Fibre Channel Protocol (FCP). Который повсеместно называют просто FC. Месяц назад Broadcom показал новое поколение FCP коммутаторов, Gen8, с коммутаторами Brocade G820 , на 128G. У окружения на FC (FCP) есть один большой плюс – туда не суют свои кривые руки так называемые сетевые инженеры. Особенно те, у которых до сих пор классы используются.

Есть один большой минус – в мире остался один поставщик коммутаторов (пропустим раздел про директоры), и это безобразно алчные капиталисты из Broadcom. Полтора поставщика, если считать остатки этого направления у Cisco. Коммутаторы у Broadcom дорогие, лицензии дорогие, итд. Кто знает и плачет над согласованием бюджетов, тому я, не очень искренне, сочувствую.

Третий, пожалуй, Infiniband. Встречаться – встречается, и коммутаторы уже дошли до 800G, например NVIDIA Quantum-X800 InfiniBand. Но не так часто и встречается. Многие купили 40G коммутаторов, с до сих пор списать не могут.

Замыкает список мутант без номера, Fibre Channel over Ethernet (FCoE). Существовал в основном в телеком секторе, но где-то в 2015 - 2020 Broadcom свернул это направление. Сейчас, может, где-то и доживает свое. Он был, он работал, через коммутаторы с отдельным FC gateway чипом.

Отдельно можно вспомнить такие явления, как NVIDIA NVLink (NVLink Switch) и Cray Slingshot (и HPC-Ethernet на его основе). Тоже протоколы.Тоже коммутаторы.

Поверх Ethernet, то есть рядом с ним, живет lossless Ethernet, он же Data center bridging, и PFC (Priority Flow Control) и ECN (Explicit Congestion Notification).

Рядом живет Ultra Ethernet.

Выше по стеку (и это единственная причина учить стек DOD) живет IP, вместе с TCP, UDP, ICMP и так далее. В том числе ipv6, который давно надо бы учить в школе.

На следущем шаге, в первую очередь стоит вспомнить про 4 основные группы протоколов: блочные, файловые, объектные, и "мутанты прочие".

С блочными совсем недавно было все совсем просто – есть FCP, есть iSCSI. В 2007 к iSCSI почти добавился iSCSI Extensions for RDMA (iSER), но сейчас производители систем хранения данных его почти не поддерживают. Можно считать, что умер раньше, чем FC. Подробности в rfc5046 - Internet Small Computer System Interface (iSCSI) Extensions for Remote Direct Memory Access (RDMA).

Недавно к этой парочке добавился RDMA over fabric (NVMe-oF). Но, как сказать «недавно». Книга NVMe Over Fibre Channel for Dummies первого издания вышла в, кажется, 2018. В 2022 было уже третье издание.

Стандарт от 2016 года, умеет его даже Oracle -

Oracle Linux UEK5 introduced NVMe over Fabrics which allows transferring NVMe storage commands over a Infiniband or Ethernet network using RDMA Technology.

С использованием этого стандарта сейчас могут работать почти все современных системы хранения данных. И включается очень просто.

Единственное "но" - "современные системы хранения данных". Никак не HP StorageWorks Modular Smart Array (MSA) 500 G2 и его ровесники типа StorageWorks Enterprise Virtual Array (EVA).

Есть большая проблема, и эта проблема – люди. Некоторые люди принципиально не понимают, чем отличается iSCSI от NVMEof, с учетом DCB, и в попытке рассказать «да это почти то же самое» придумывают свою терминологию, вместо использования английского. Возможно, это жертвы цыганских курсов по вкатыванию в ИТ, пытаются что-то вспомнить.

С файловыми протоколами тоже все просто. Есть много лет используемый SMB. Причем, это не только «файловые шары под Windows», это еще и s2d.

Networking Hardware. Storage Spaces Direct uses SMB3, including SMB Direct and SMB Multichannel, over Ethernet to communicate between servers. We strongly recommend using 10+ GbE with remote-direct memory access (RDMA), either iWARP or RoCE.

Storage Spaces Direct overview

Есть NFS. Не понимаю, почему его так любят некоторые граждане, ввиду всего интима с стандартом 4.1

NFS очень много где «есть», особенно при использовании систем хранения от Netapp.

С объектными стандартами, или протоколами, тоже все относительно просто. Есть Amazon S3, и есть его вариации и реализации (Minio, Seaweed, etc). Рассмотрение остальных 20+ вариантов, начиная с Azure Blob Storage, выходит за пределы заметки, написанной за 30 минут. В том числе потому, что для доступа к Azure используется NFS, и не только. Если вы можете это прочитать в статье Access data from Azure Blob Storage by using multiple protocols, то вам не нужны очки. Даже от Specsavers.

Отдельно живут разнообразные мутации, проприетарные, и не очень. Из того, что сразу можно вспомнить, это vSAN и его приприетарный Reliable Data Transport (RDT). Он объектный, но, по моему особо ценному мнению, все же мутант.

Сюда же можно отнести RADOS (Reliable Autonomic Distributed Object Store) и messenger v2 protocol. Надеюсь, вы знаете, что это, и где используется.

Итого

Знание всего вышеперечисленного нужно в трех случаях

Первый случай. Вы проходите интервью, и вас спрашивают все подряд, в том числе, с чем работали, и что знаете. Тут могут и про классовую адресацию спросить. Если спросят – БЕГИТЕ ОТТУДА.

Второй случай. Вы работаете в фирме, где активно используются все вышеперечисленное, и еще немного всякого. Например, Longhorn.

Третий случай. Вам надо выбрать, на что вы будете переходить с FC (FCP) – на Arista (AMD - Xilinx) или на Mellanox (Nvidia).

В список не попали Network block device, DRBD (потому что там протоколы означают совсем другое) и много чего еще, но про это или было сказано раньше, или, может, кто-то в комментариях напишет.

Заключение

После всего сказанного, сами протоколы не так важны, как решение, или набор решений, которые будут выбраны для работы бизнес-задач. Нужно хранить много мелких файлов - будет что-то на тему s3. Сами s3 ноды могут (и будут) в контейнерах или в VM, а под ними уже будет NFS, SMB, и что там еще нужно.

Нужно хранить не так много файлов, например нужна одна, но большая база данных - будет выбрано то, что дешевле внедрить и эксплуатировать, с заданной надежностью. И так далее.

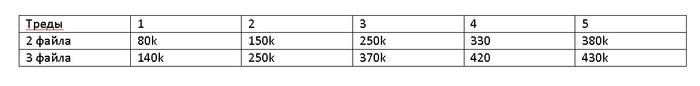

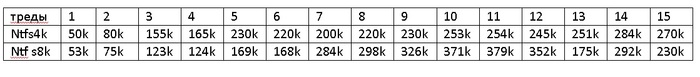

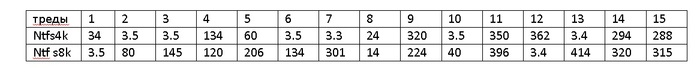

PS. Longhorn был «не очень», таким и остался. Достаточно посмотреть результаты тестов 2 летней давности на serverfault, или на v2-data-engine. Я даже сначала не понял, почему тестирование для 1.7 и 1.10.1 настолько совпадает.

Литература для отставших в развитии на уровне 1993 года