Я долго относился к этому скептически: казалось, что нейросеть для говорящих фото в лучшем случае даст эффект “маски” с неестественной мимикой. Но однажды мне нужно было быстро сделать ролик, где человек на снимке произносит несколько фраз — без съемки, микрофона и многочисленных дублей. Я загрузил фотографию, добавил текст и получил результат, который выглядел заметно убедительнее, чем я ожидал.

После этого я решил разобраться основательно: протестировал около 20 сервисов и сравнил синхронизацию губ, мимику, уровень реализма и удобство работы. В итоге я отобрал личный ТОП-10 — варианты, где действительно можно сделать говорящее фото без лишних сложностей и с результатом, который подходит для публикации и рабочих задач.

ТОП-10 нейросетей чтобы сделать говорящее видео из фото в 2026 году

Study AI — ИИ для говорящего фото, минимум настроек, удобно для первых попыток.

SORA — больше про эффектные видео и креатив, но нужен аккуратный промпт и терпение.

GPTunneL — дает более реалистичную мимику и синхронизацию губ, хорошо подходит для “живого” результата.

Apihost — удобен, если нужно генерировать много роликов и подключать все через api.

GoGptRu — простой интерфейс и шаблоны, когда хочется получить результат без лишней возни.

MashaGPT — нейросеть для создания говорящих фото работает в формате чата: загрузили изображение, написали текст, получили говорящий ролик.

ruGPT — заточен под русский язык и типовые задачи, хорошо для обучения и бизнес-видео.

AISearch — как витрина моделей: удобно сравнить варианты и выбрать лучший под ваше фото.

Chad AI — быстрый вариант для коротких роликов и мемов, упор на скорость, а не суперреализм.

GenAPI — нейросеть, чтобы заставить фото говорить, больше контроля и качества, но чуть сложнее в освоении.

На своем опыте заметил, что готовый ролик получается естественным и подходит для соцсетей, поздравлений или мини-презентаций — достаточно загрузить фото и указать стиль. Единственный момент — это не строго “говорящее фото” с полной синхронизацией речи, но именно как оживление и анимация кадров работает действительно достойно. В целом, Study AI — это платформа с кучей ИИ-инструментов в одном месте, где этот модуль — удобный вариант для базовой анимации по фото.

Стоимость: бесплатная нейросеть для говорящего фото

Что умеет: оживляет фото в видеоролик, плавные переходы, анимирует лица и движения из изображений

Качество: норм

можно сделать фото говорящим с помощью нейросети в браузере без установок и сложных настроек;

много инструментов под одной подпиской;

подходит для соцсетей и простых проектов;

подходит новичкам без опыта видеомонтажа.

Сервис особенно полезен, если вы хотите не просто “говорящее лицо”, а реально динамический ролик, где фото превращается в сцену с движением и эффектами — это почти как мини-кино, которое вы описываете словами. В процессе я заметил, что Sora дает ощутимо более гибкий контроль над результатом, чем обычные шаблонные генераторы, но при этом требует чуть больше внимания к промпту. Если вы любите экспериментировать — это отличный вариант для креативных задач, презентаций и соцсетей. Главное — понимать, что это больше генерация видео, чем банальная мимика на фото.

Стоимость: обычно доступ через подписку на платформу (варианты с разными лимитами генераций и параметрами качества)

Что умеет: создавать говорящее фото нейросетью онлайн

Качество: высоко (в зависимости от промпта и параметров)

дает действительно динамичные видео с эффектами и движением;

гибкий контроль через текстовые подсказки;

подходит для креативных идей и нестандартных задач;

генерирует ролики, которые выглядят более “киноматографично”.

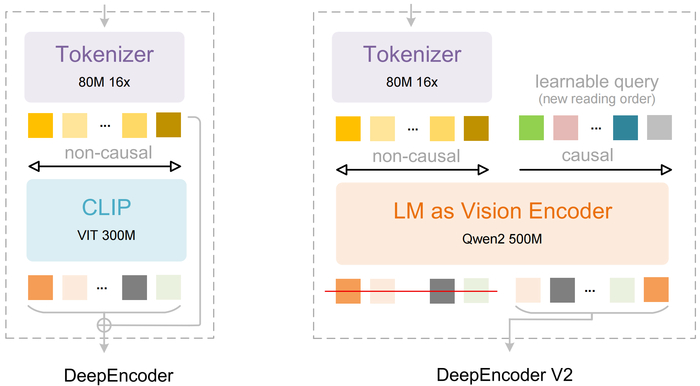

В отличие от простых “говорящих фото”, в этом инструменте вы получаете широкие возможности визуального редактирования и контроля качества, что пригодится, если вы хотите не просто оживить лицо, а придать ему контекст, фон или атмосферу. Лично я использовал его, чтобы сделать серию кадров для сторителлинга и визуальных историй — результаты получаются более художественными и детализированными, чем в большинстве стандартных генераторов. Это больше про высокое качество изображения и гибкость, чем про простой формат “лицо говорит текст”, но для тех, кто хочет прокачать визуал, это отличный вариант.

Стоимость: зависит от выбранной модели и типа генерации (цена за изображение/секунду видео/аудио), платите только за то, что используете

Что умеет: говорящее фото с помощью ИИ, мощная генерация и редактирование изображений по тексту или фото, контроль стиля, композиции, высокая детализация

Качество: высоко

гибкий инструмент для визуального творчества и редактирования изображений;

высокая детализация и контроль стиля;

подходит для маркетинга, сторителлинга и художественных задач;

система оплаты “платите за генерацию”, без фиксированной подписки.

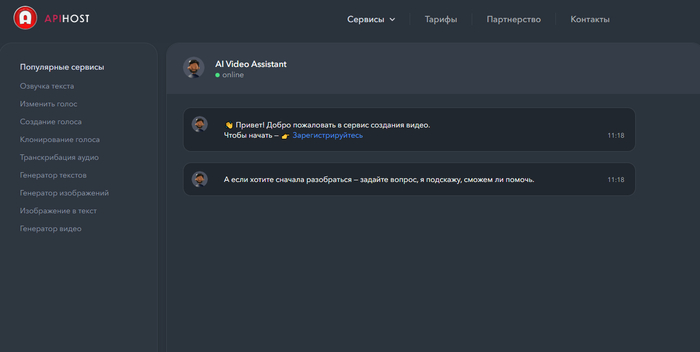

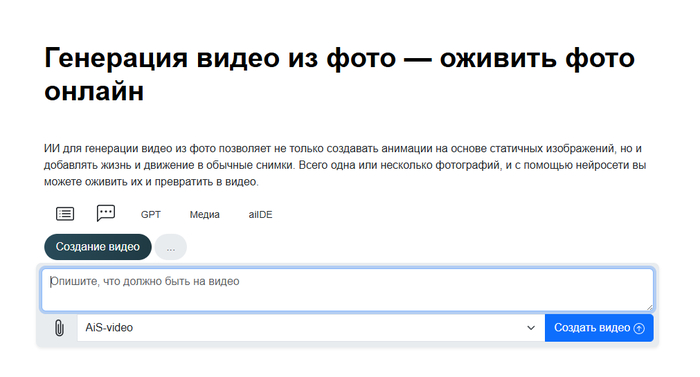

Этот генератор особенно выручает, если нужно быстро получить “фото в видео” без сотни настроек — результат выходит динамичным и подходит прямо для соцсетей, сторис или маркетинговых карточек. Лично я использовал его, чтобы сделать короткие анимации для рекламы — по времени это занимает пару минут, а эффект намного круче, чем просто статичная картинка. Конечно, это все еще короткие видео, но они выглядят живыми и интересными, особенно если добавить подробное текстовое описание сцены.

Стоимость: примерно 9 ₽ за секунду финального видео

Что умеет: сделать говорящее фото через нейросеть по текстовому описанию, добавляет движения и эффекты

Качество: норм–высоко (для коротких видео)

превращает обычную фотографию в динамичное видео за пару шагов;

короткие ролики хорошо заходят в соцсетях и для рекламы;

понятный процесс: загрузил фото → описал сцену → получил MP4;

подходит для маркетинговых карточек и сторис;

прозрачная тарификация по секундам.

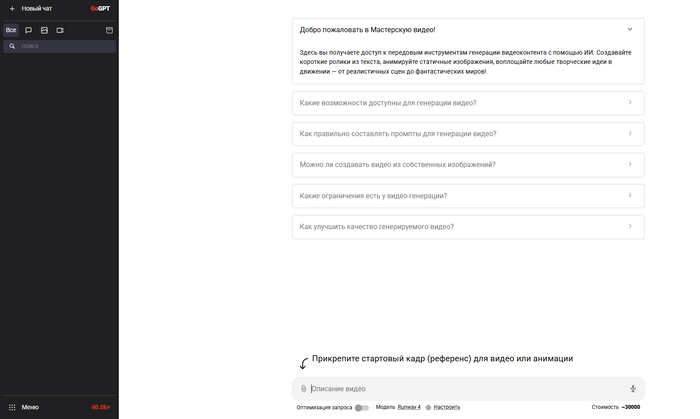

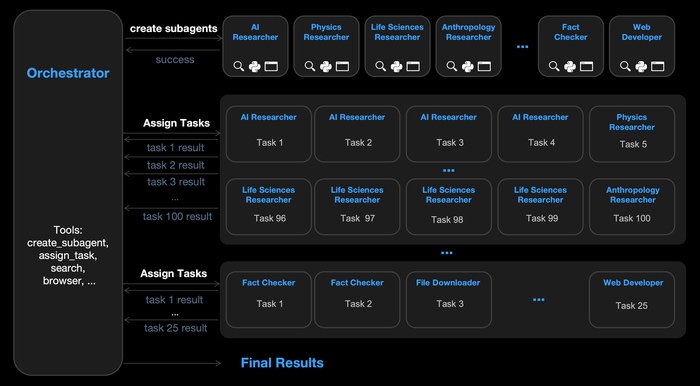

В отличие от узкоспециализированных инструментов, здесь вы выбираете модель (например, видеогенераторы вроде Runway или Higgsfield) под вашу задачу и сразу переходите к генерации, что экономит время при экспериментах с разным стилем и качеством. Сам я пробовал здесь анимировать фото в короткие сцены — результат зависит от выбранной модели, но в целом GoGPT дает простор для творчества и экспериментов. Это не только про “говорящие фото”, но и про мультимодальные возможности, когда фото становится частью более сложного видео или визуального контента.

Стоимость: зависит от выбранных моделей и тарифов

Что умеет: агрегирует разные нейросети для изображений и видео (например, генерация видео по фото/запросу через видеомодели)

Качество: норм–высоко (вариативно в зависимости от модели внутри)

большой выбор ИИ-моделей в одном месте;

можно экспериментировать с разными инструментами без перехода по отдельным сайтам;

доступны мощные модели видео и анимации;

подходит для разных задач от создания изображений до видео;

интерфейс позволяет легко пробовать разные подходы.

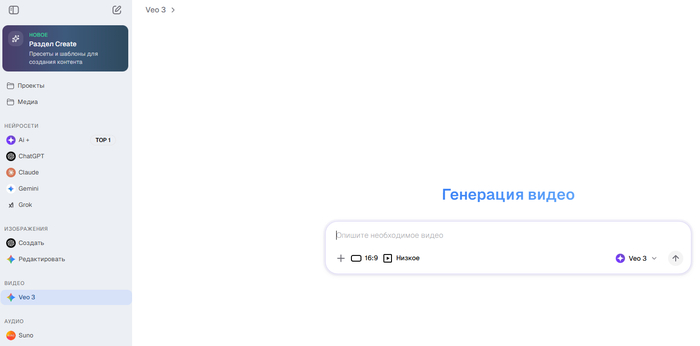

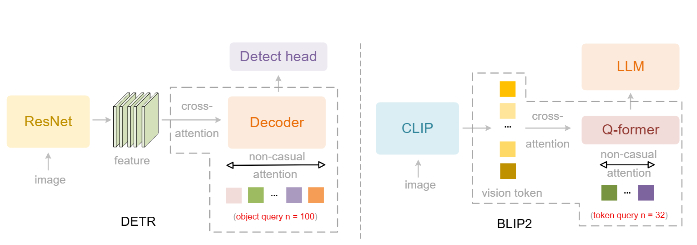

С Veo 3 я делал из простых снимков небольшие анимации с движением камеры и эффектами — для приветственных видео и сторис получилось лучше, чем ожидал. Плюс сам интерфейс чат-бота помогает формулировать, что именно вы хотите получить, и иногда сам подсказывает варианты. Это не про глубокую синхронизацию речи, но как средство превратить статичное фото в живой ролик — очень достойный вариант.

Стоимость: базовый функционал доступен с токенами/лимитами, продвинутые генерации видео требуют платного доступа

Что умеет: говорящее фото нейросетью на русском

Качество: норм–высоко (в зависимости от промпта и параметров)

объединяет много AI-моделей в одном месте;

генерация коротких видео из фото через Veo 3;

удобный интерфейс чат-бота, подсказывает, что можно сделать;

подходит для сторис и коротких роликов;

на русском языке и с понятными командами.

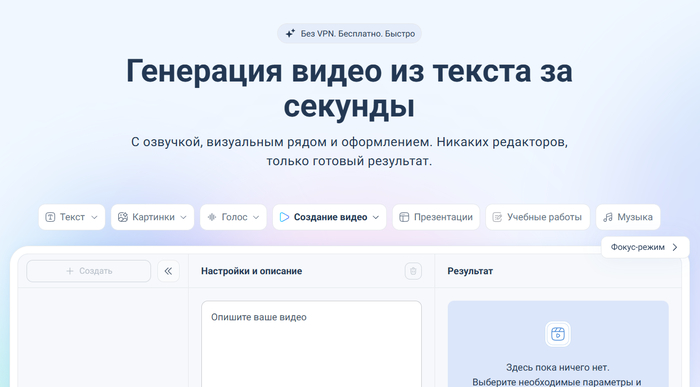

Сервис отлично справляется с роликами под соцсети, сторис или короткие анонсы — достаточно просто написать, о чем должен быть видео-клип, выбрать формат, и инструмент автоматически создает визуал и звук. Я использовал его, чтобы быстро сделать визуал для тизеров и презентаций — и получилось понятное, яркое видео буквально за минуты. Это удобный вариант, если нужно быстро получить динамичный ролик из фото или текста.

Стоимость: платный доступ по тарифам сервиса (лимиты генераций/подписка)

Что умеет: превращает текст или фото в короткий видеоролик с озвучкой и визуальными эффектами

Качество: норм–высоко (для коротких роликов)

автоматически собирает видео «под ключ» — визуал + озвучка + оформление (тексты, фон, эффекты);

оживление фото в динамический клип без навыков монтажа;

быстро работает — готовый ролик за секунды;

можно использовать для анонсов, объяснений, мемов и промо.

Для меня это стало отличным вариантом, когда нужно быстро сделать живую анимацию для сторис или презентации из обычной фотографии без монтажа — все происходит буквально в пару кликов. Интерфейс достаточно интуитивный, а итоговый ролик можно дополнить звуком и эффектами перед экспортом. Конечно, это не профессиональная синхронизация речи, но как оживление фото в видео с эффектами и движением выглядит реально неплохо.

Стоимость: зависит от тарифа

Что умеет: оживляет фото в видео длительностью до ~22 сек, анимирует глаза, улыбку и движения головы, добавляет эффекты и дорожки

Качество: норм

простой и быстрый процесс — от фото к видео за пару минут;

поддерживает базовые эффекты и анимации;

нейросеть, где фото говорит по тексту, можно добавить звуковую дорожку или спецэффекты.

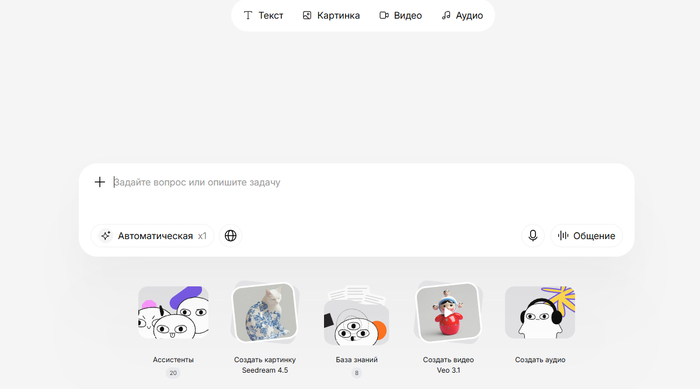

За счет этого я мог быстро переключаться между задачами: оживить фото, сгенерировать видео по тексту или собрать динамичные сцены в одном месте. В моем опыте это удобнее, чем прыгать между разными сервисами, особенно когда проект сочетает анимацию, визуал и озвучку. Правда, результат сильно зависит от выбранной модели внутри платформы, но если грамотно подобрать инструмент (например, Veo 3 для видео), можно получить впечатляющий ролик буквально за пару минут.

Стоимость: платный доступ по подписке с тарифами на генерации видео/текст/изображения и лимиты по количеству материалов

Что умеет: оживлять фото, генерировать видео из текста/изображений, анимировать и добавлять спецэффекты

Качество: норм–высоко (зависит от выбранной модели внутри сервиса)

объединяет сразу много мощных нейросетей в одном месте;

можно быстро переключаться между задачами (текст, видео, изображение);

подходит для экспериментов и сложных визуальных задач;

поддержка современных видеомоделей (Veo 3, Sora и др.);

удобный интерфейс с быстрым доступом к результатам.

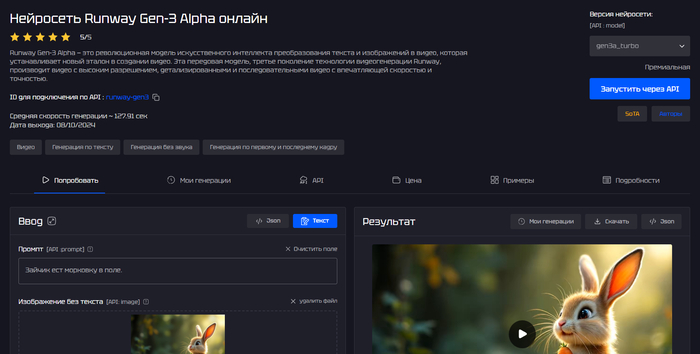

Я использовал ее для создания коротких анимаций по идее, и впечатлило, что результат далеко не “плоский”; движения чувствуют себя живыми, а детали продуманы. Это не самый простой путь к “говорящему фото”, но если вам нужны динамичные видео из статичных материалов с большим контролем над стилем и сценой, то Runway Gen-3 через GenAPI — один из лучших вариантов.

Стоимость: платно по генерациям (примерно ~60 ₽ за 5 сек, ~120 ₽ за 10 сек) — платите только за то, что создаете

Что умеет: превращает текст и изображения в видео, оживляет фото с движением, может генерировать клипы по описанию, поддерживает разную длину роликов

Качество: высоко — детализация, последовательность кадров и визуальная четкость на уровне современных видео-ИИ

мощная модель с кино-уровнем качества видео из фото/текста;

гибкий контроль над сценой и движением через промпт;

нет фиксированной подписки — оплачиваете только генерации;

подходит для маркетинга, презентаций, сторителлинга и соцсетей;

поддерживает разные подходы: текст→видео, изображение→видео.

требует четкого описания в промпте для хорошего результата;

платная модель, особенно заметно при длительных роликах.

Как заставить фото говорить с помощью нейросети

Если вы спросите меня, как заставить фото говорить с помощью нейросети, я отвечу так: это больше похоже не на “оживление картинки”, а на маленькую постановку. Нейросеть не просто двигает рот — она пытается собрать цельное ощущение живого человека: мимика, микродвижения, взгляд, иногда даже легкий поворот головы. И вот тут у многих случается разочарование: берут первое попавшееся фото, вбивают текст, жмут “сгенерировать” — и получают странную “маску”. Я через это тоже прошел, поэтому теперь отношусь к процессу как к настройке инструмента: чтобы результат был нормальным, нужно дать нейросети правильный “сырье”.

Самое важное, что я для себя понял: 70% успеха — это исходное фото и звук. Если на снимке лицо ровно, хорошее освещение, нет сильных искажений и человек смотрит примерно в камеру — нейросеть почти всегда отрабатывает заметно лучше. Дальше вы выбираете: либо “говорить по тексту” (когда сервис сам озвучит и синхронизирует губы), либо “говорить по аудио” (когда вы загружаете голос, и нейросеть под него подгоняет мимику). И вот второй вариант обычно выглядит правдоподобнее, потому что у живого голоса есть ритм и эмоция — нейросети проще попасть в естественность. В итоге схема простая: берете удачное фото, короткий текст без скороговорок, выбираете сервис с нормальной синхронизацией — и получаете то самое “говорящее фото”, которое не стыдно показать.

В итоге нейросеть для говорящих фото — это уже не эксперимент “ради интереса”, а вполне рабочий инструмент для контента, обучения и простых маркетинговых задач. Если выбрать подходящий сервис и использовать качественное исходное фото, результат получается убедительным: мимика выглядит живее, движения — естественнее, а сам ролик можно спокойно использовать в соцсетях или презентациях. Я бы советовал начинать с тех вариантов, где проще всего добиться стабильного результата, а затем переходить к более гибким решениям, если нужен максимальный реализм и контроль.