Искусственный интеллект

Mistral выпустил распознаватель PDF-файлов

📄 Mistral выкатили распознаватель PDF-файлов и документов.

OCR-модель распознает текст (в том числе на русском, таблицы, изображения и формулы. Точность достигает 94,89%, а это выше, чем у Google Document AI (83,42%) и Azure OCR (89,52%).

👀 Бесплатно попробовать можно в Le Chat или через API . Есть готовый колаб , вам остаётся в нём:

🟡Подставить API в строчку api_key (можно бесплатно взять здесь ) ;

🟡Закинуть файл в папку слева и заменить pdf_file = Path на название вашего документа.

Будущее наступает

источник: https://t.me/hum_techie/11

Беспредел уровня рисков в разработке общего ИИ1

Я разработчик машинного обучения в области компьютерного зрения. Я посвятил свою карьеру автоматизации, чтобы наша цивилизация могла пользоваться большим количеством благ, прикладывая меньшее количество усилий. Я писал алгоритмы обучения нейросетей, которые позволяют роботам доставщикам замечать детей и объезжать их. Я обучал нейросети ловить мошенников, подделывающих фотографии для банков и для маркетплейсов. Я писал алгоритмы, детектируюшие брак на заводах производства медицинских товаров. И вот как раз на одном из таких заводов я столкнулся с вполне стандартной бюрократией. Бла бла бла, надо думать о безопасности. И таблица, как это правильно делать. Суть таблицы сводилась к тому, что если изменение процесса производства вызывает уровень риска выше, чем 0.01% матожидания смертей в год, то такие изменения не допускаются. Да, при расчёте рисков приходится вводить допустимый уровень риска смерти. Убивать людей нельзя. Рисковать убийством людей - тоже нельзя. Но совсем без рисков обойтись невозможно. И вот этот самый порог расчётного количества смертей определён как 10^-4 в год. Это не только в той организации так, это в целом глобально по всей планете так, порог разный, где-то 10^-3, где-то строже это правило выполняется, где-то менее строго. Во многих странах это закреплено законодательно, например в Британии. Хотите построить гидроэлектростанцию? Перемножьте расчётную вероятность того, что она рухнет, на число людей в области затопления - и если ожидаемое число жертв в год выше 10^-4, то план строительства не будет одобрен - укрепляйте конструкцию. То же самое с атомными реакторами, и прочими конструкциями, создающими риски для населения. Конечно где-то проще закрыть на это глаза, где-то коррупция, где-то дешевле оплатить штраф, но общее направление такое.

А теперь общий искусственный интеллект. В науке нет консенсуса о том, насколько он безопасен. Теоретические изыскания о контроле сильного общего ИИ говорят об отсутствии способов гарантировать сохранение контроля. Я не стану расписывать всю логику теории контроля сильного ИИ в этом посте, хотя мне много чего есть сказать на этот счёт. Если будет интерес - напишу. Скажу лишь то, что больше половины респондентов среди исследователей искусственного интеллекта считают, что риск того, что сильный ИИ уничтожит человечество в ближайшие 100 лет превышает 5% https://aiimpacts.org/2022-expert-survey-on-progress-in-ai/ . Главы лабораторий оценивают этот риск в 10%-20%+ https://en.m.wikipedia.org/wiki/P(doom). И не стоит ориентироваться на цифру 100 лет - сильный общий искусственный интеллект появится гораздо раньше. Больше половины пользователей платформы предсказаний metaculus считают, что он появится до 2031 года https://www.metaculus.com/questions/5121/date-of-artificial-...

И вот всё это вызывает у меня вопрос. Кем возомнили себя разработчики общего искусственного интеллекта, что решили, что их индустриальная отрасль настолько важнее всех других отраслей, что они могут себе позволить превышать допустимые пределы подвергания окружающих опасности не в 2 раза, не в 10 раз и не в 1000 раз, а в триллион раз?

Перспективный союз: почему ИИ и блокчейн нужны друг другу

В предыдущем посте я рассказывал про роль блокчейна в децентрализованном обучении ИИ. Однако есть еще несколько важных направлений, где на стыке ИИ и блокчейна возникает мощный синергетический эффект.

Борьба с фейками. Сегодня мир захлестывает волна синтетического контента и становится все сложнее отличить генерации от оригинала. Как не попасть в ловушку дипфейков?

Блокчейн предлагает один из способов проверки подлинности. Он использует распределенный реестр с криптографическими записями, временными метками и фиксацией первоисточника, которую невозможно подделать.

Важно понимать, что сам по себе блокчейн не определяет, был ли файл создан ИИ или обычной камерой (для этого нужны ИИ-детекторы), но он гарантирует, что уже записанные данные не могут быть изменены или удалены задним числом.

Прозрачность ИИ-агентов. «Рассуждающие» модели опираются не только на внутренние знания, но и на собственные «размышления». Если зафиксировать эти метаданные в блокчейне, разработчики ИИ-агентов смогут отслеживать логику принятия решений, выявлять ошибки и точнее дообучать модели. Это позволяет понять, по каким причинам тот или иной ИИ-агент пришел к определенному выводу в сложных роботизированных и IoT-системах.

Цифровая идентичность. Представьте, что у вас есть «цифровой двойник», который общается в сети от вашего имени, совершает транзакции и даже голосует в DAO. Чтобы такой агент не вышел из-под контроля, нужны четкие механизмы идентификации и ограничения прав — децентрализованная цифровая идентичность (DID). Вы указываете, где и как агент может действовать, а блокчейн подтверждает личность и сохраняет неизменность записей.

Интернет ончейн-агентов. В результате мы получаем целый «интернет агентов». Каждый пользователь создает ИИ-агента, обученного на собственных данных, и делегирует ему часть рутинных задач, а все действия фиксируются в распределенной сети.

В перспективе это приведет к созданию новой экономики интеллектуальных услуг. Пользователи будут отправлять запросы в сеть, а рой ИИ-агентов самостоятельно распределит задачи, выберет оптимальные методы и исполнителей, а затем выполнит работу.

Коллективная ответственность. Закрытые ИИ-модели напоминают «черный ящик», где все данные и алгоритмы контролирует одна корпорация. При децентрализованном обучении исходные данные распределены между участниками, и каждый может удостовериться в их подлинности. Ответственность за обучение делится между всеми, а не лежит на одном игроке.

Когда блокчейн-сеть использует вычислительные мощности не для поиска хешей, а для ИИ-задач, мы говорим о «майнинге вычислительных ресурсов». Это дает возможность тысячам частных узлов предоставить свои мощности для обучения ИИ и получать за это вознаграждение.

Думаю в ближайшее время появятся DAO для координации процесса обучения нейросетей. Они будут распределять вознаграждения и регулировать процесс на основе этических норм.

По-настоящему «умные» смарт-контракты. Сегодня смарт-контракты — это жестко прописанные правила, которые автоматически выполняются при соблюдении определенных условий.

Благодаря интеграции ИИ, можно анализировать данные в реальном времени, учитывать сложные факторы (рыночные условия, поведение пользователей, внешние события) и корректировать выполнение условий на лету.

Так появляются самообучающиеся смарт-контракты, которые повышают эффективность DeFi-протоколов, оптимизируют распределение ресурсов в DAO и автоматически выявляют подозрительные транзакции.

Синергия ИИ и блокчейна — это закономерный этап эволюции обеих технологий. Блокчейн обеспечивает прозрачность и безопасность, а ИИ дает возможность адаптивно управлять сетью и решать сложные задачи, ранее лежавшие на человеке.

В итоге мы получаем экосистему, в которой можно безопасно обучать модели, бороться с фейками в соцсетях и даже создавать ИИ-агентов, действующих от нашего имени.

При этом механизм коллективной ответственности подчеркивает важную мысль: «мы в ответе за тех ИИ-агентов, которых обучили».

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал — там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

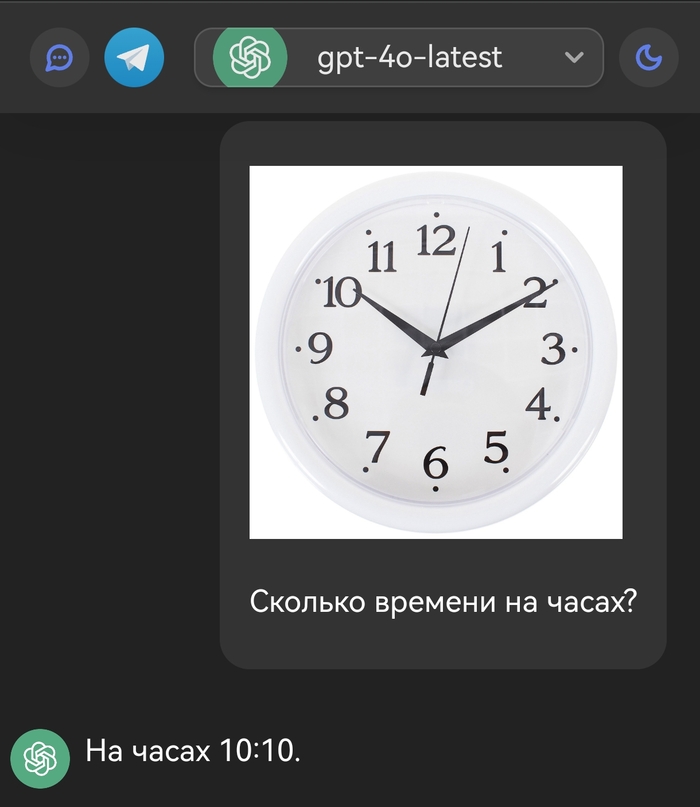

ChatGPT — не зумер

Видел недавно пост, где ChatGPT называет неправильное время на часах. Миф опровергнут :)

Скриншот, кстати, с нашего сайта, который мы разрабатываем. Скоро будет публичный тест!

WithSubtitles добавляет субтитры к видео

🔥 WithSubtitles — топовый, БЕСПЛАТНЫЙ😎 сервис, позволяющий автоматически добавлять субтитры к вашим видео. Обеспечивает конфиденциальность, позволяя работать прямо в браузере без необходимости загружать что-либо на серверы.

⚙️ Ключевые особенности:

💬 Автоматическое распознавание речи: Сервис использует передовые технологии для точного распознавания аудио и генерации субтитров с точным таймингом.

💬 Настраиваемые шрифты: Встроено множество шрифтов, которые можно кастомизировать под свои предпочтения, обеспечивая уникальный стиль субтитров.

💬 Поддержка видео любой длины: Сервис способен обрабатывать как короткие ролики, так и полнометражные фильмы, обеспечивая гибкость для пользователей с различными потребностями.

Моргают диоды

На вытяжке заменил лэд драйвер и перепаял диод, при проверке (всё ли работает) диоды горят всë норм, как только припаиваю проверяю они моргают. Несколько раз попробовал не осилил. Подскажите что делать. ???

Ответ на пост «Интересный баг чата GPT»1

Почему нейросеть не рисует одну розу и букву "V"? Мы провели расследование

Недавно в DALL·E (нейросети OpenAI для генерации изображений) обнаружили странный баг — она отказывается рисовать одну розу и букву "V". Это вызвало много вопросов, и мы решили докопаться до истины.

Провели серию контрольных тестов, чтобы выяснить, какие объекты блокируются и что их объединяет. Вот что мы выяснили:

Что DALL·E блокирует?

❌ Одиночную розу — но букет рисует без проблем.

❌ Букву "V" — но другие буквы, например, "X", проходят.

❌ Маску Гая Фокса — но обычную белую театральную маску можно.

Что DALL·E НЕ блокирует?

✅ Букет роз — фильтр настроен только на одиночный цветок.

✅ Человека в черном плаще и шляпе — если не упоминать "V for Vendetta".

✅ Серп и молот, китайскую коммунистическую пропаганду — значит, дело не в общей цензуре против левых идей.

В чём причина?

После анализа стало очевидно: все заблокированные элементы связаны с "V for Vendetta" и символикой восстания. Красная роза, буква "V" и маска Гая Фокса — это культовые образы революции, сопротивления и анархии.

Вероятные причины фильтра:

1. OpenAI не хочет, чтобы DALL·E создавал символику протестов и восстаний.

2. Система блокирует "опасные" символы, чтобы их не использовали в политических кампаниях.

3. Возможно, это просто баг, но он явно настроен очень точечно.

Вывод

DALL·E не блокирует коммунизм, социализм или анархизм в целом, но выборочно фильтрует ключевые символы восстания. Это значит, что OpenAI активно контролирует, какие изображения можно генерировать, а какие нет, причём на уровне отдельных слов.

---

Если кто-то хочет проверить сам — попробуйте сгенерировать одну розу, букву "V" или маску Гая Фокса. А если найдете ещё заблокированные символы — пишите, будет интересно расширить этот список!