Как проще всего наложить 3D-персонажа на актера в видео?

Дамы и господа видеомонтажёры и видеографы! Я не видеомонтажёр, мой потолок – нарезать и склеить видео, подложить звук – в общем, развлечения второклашки на переменке. Прошу советов или идей у бывалых.

Появилась идея снять серию видео для соцсетей для моего магазинчика, в которых в кадре всё рассказывал бы 3D-персонаж. Рисовать такое видео целиком в Максах-Блендерах – дорого, долго, больно, бессмысленно и беспощадно. Ищу способ наложить персонажа на живого актера в видео. Скажите, пожалуйта, существуют ли какие-то готовые заточенные под это программы или нейронки, какие-то способы, чтобы это работало так же просто, как, например, AR-маски в Snapchat?

Снимается в помещении, статично, актёр просто стоит или сидит за столом.

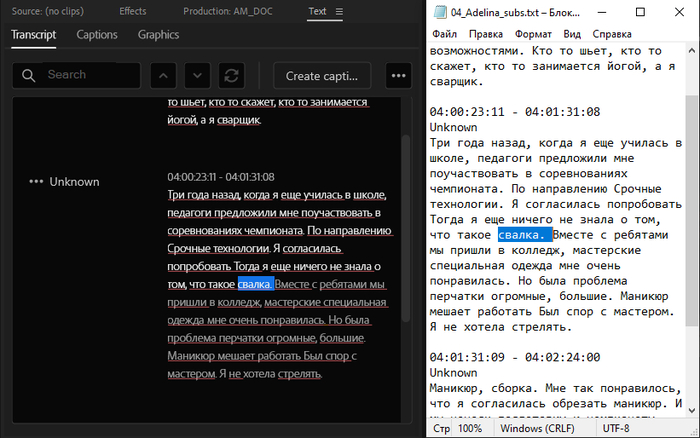

Картинка, конечно же, для привлечения внимания.