🥈 Aeza.ru - максимальная скорость на Ryzen 9 и антирекорд задержек для стриминга токенов

🥉 4VPS.su - стартуй бюджетно в РФ и 30+ странах, масштабируй ресурсы по щелчку

🏆 Timeweb.com - гибкий почасовой биллинг для экспериментов с LLM и RAG

🏆 FirstVDS.ru - стабильность 24/7 и разные линейки тарифов под нагрузку ботов

🏆 AdminVPS.ru - NVMe, ежедневные бэкапы, безлимит на ряде планов — бери под API на выходные

🏆 VDSina.ru - честные конфиги на AMD EPYC и 32 ТБ трафика под ботов с голосом

🏆 Beget.com - бесплатные авто-бэкапы и SLA 99,98% для продакшн-приложений с LLM

🏆 SprintHost.ru - порт 10 Гбит/с, чтобы стримить ответы LLM без заиканий

🏆 FastFox.pro - простой старт для локальных моделей, недорого и без боли

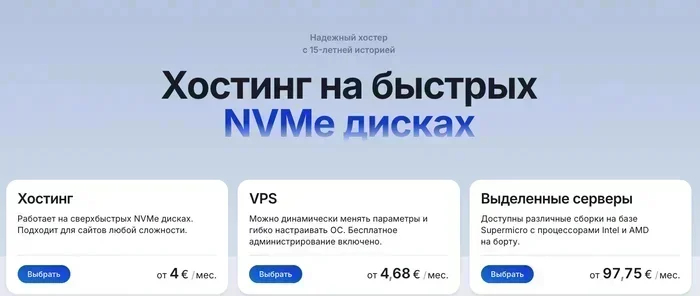

🏆 Fornex.com - зарубежные площадки под приватные ассистенты и аналитические пайплайны

Что на самом деле важно для сервера под LLM

Меня часто спрашивают: «Нужна ли видеокарта?» Если у вас инференс на больших моделях (70B+) и жесткие SLA — скорее всего да, причём с приличным объёмом VRAM. Но большинство реальных сценариев — переписка, резюмирование, извлечение сущностей, простые RAG — спокойно живут на CPU, особенно если использовать квантованные сборки (q4_k_m, q5_0, GPTQ, GGUF) и движки вроде llama.cpp, vLLM или text-generation-inference. И вот тут VDS оказывается сладким компромиссом: NVMe для быстрых загрузок, приличный vCPU, память от 8 до 32 ГБ и нормальная сеть.

Есть ещё пара невидимых героев. Репутация IP — чтобы вебхуки не тонули в блокировках и антиспаме. Адекватная DDoS-защита — чтобы боты не падали в момент, когда они понравились людям. И холодная голова при настройке: hugepages, NUMA awareness для больших RAM, аккуратная настройка ulimits и swap, авто-бэкапы, мониторинг в пару кликов. Всё это делает не просто «сервер», а удобную платформу под ваши LLM-идеи.

ISHosting

ISHosting — тот случай, когда география решает. Локаций — больше сорока стран и четыре десятка городов, так что можно разместить бота ближе к аудитории и снизить задержку стриминга токенов. VPS на KVM и диски на SSD/NVMe — бодрая база под квантованные модели, а для сложных задач есть выделенные серверы, которые гибко собираются под ваш сценарий. Порт 1 Gbps, аптайм 99.99%, базовая DDoS-защита — всё по-взрослому, без приглушенных «ой» в пиковые часы.

Люблю у них прозрачность. IPv4 можно докупить, IPv6 дают щедро (до /64), бэкапы — раз в неделю, а тест Linux VPS — до семи дней (Windows — до 24 часов). Хочется пощупать — пожалуйста, запускайте, мерьте токены в секунду, гоняйте RAG. Оплата как удобно: карты, СБП, ЮMoney, крипта. Мелочь, а душу греет.

Что особенно приятно для LLM-разработчика — нет скрытых лимитов на CPU, можно смело докручивать потоки при прогреве индекса, делать бенчмарки и не оглядываться каждые три минуты. А панелей хоть отбавляй — ISPmanager, Hestia, DirectAdmin — под какой стек привыкли.

🚀 KVM и NVMe — уверенный инференс и быстрая подгрузка весов

🌍 40+ стран — минимальная задержка для вашей аудитории

🛡️ Базовая DDoS-защита и высокий SLA 99.99%

💾 Weekly-бэкапы — спокойное тестирование без страха потерять прогресс

🔌 Порт 1 Gbps — нормальный стриминг ответов

🧪 Тест Linux VPS до 7 дней — проверяете модель без риска

📦 IPv6 бесплатно до /64, IPv4 — по вменяемой цене

🧰 Панели ISPmanager/Hestia/DirectAdmin

💳 Оплата картами, СБП, кошельками и криптовалютой

🧠 Без скрытых лимитов CPU — честная производительность

👉🏻 Перейти на официальный сайт ishosting.com

Aeza

Aeza — это про скорость и «небо над головой без лимитов». Ryzen 9 9950X, NVMe, до 25 Гбит/с и ∞ трафика — если вы любите стримить ответы LLM буквально в реальном времени, будет приятно. Анти-DDoS до 2 Тбит/с и включенный IPv4 с широкой IPv6-подсетью (/48) намекают: можно выпускать публичные API без фобии, что первый же хайп сломает домик из карточек.

Цены по Москве понятны: как Shared, так и Dedicated vCPU. Нужна предсказуемость при нагрузки? Берите выделенные ядра, меньше сюрпризов с латентностью. Нужна экономия? Shared подойдет под лёгкий инференс, менеджмент очередей и пулы воркеров.

Платить можно чем удобно — МИР, СБП, YooMoney, да и «карта любого банка» там встречается. В целом ощущение от Aeza — современный сервис, где хочется запускать живые штуки и не заикаться при скорости.

⚡ Ryzen 9 9950X — высокий IPC для токен-стриминга

🌐 До 25 Гбит/с — мгновенный отклик UI и API

🛡️ Anti-DDoS до 2 Тбит/с — держит удар

📨 IPv4 включён, IPv6 /48 — гибкая сетевуха

💸 Понятные тарифы Shared/Dedicated vCPU

♾️ Безлимитный трафик — удобно для демо и публичных ботов

🕹️ Удобные платежи: МИР, СБП, YooMoney

🧪 Гибкость в конфигурациях — легко подобрать под задачу

📈 Хорош для RAG и стриминговых ассистентов

🔧 Быстрая настройка окружения

👉🏻 Перейти на официальный сайт aeza.ru

4VPS

4VPS нравится географией и демократичным входом. Россия и три десятка стран, 36 дата-центров, а стартовые тарифы в РФ — как чашка кофе. Для LLM это значит просто: можно разворачивать локальные ассистенты ближе к команде или клиенту, и не переплачивать за лишние гигабайты, которые пока не нужны.

Там KVM и NVMe, базовая DDoS-защита, SLA 99.9%. IPv4 один включён, IPv6 /64 — для сервисов, где хочется сразу добавить современную сетевую адресацию. А ещё можно апгрейдить ресурсы поштучно — добавили ядро, докинули RAM, расширили диск. Приятно, когда масштабирование — не квест.

Тестовый период до 24 часов по заявке спасает от импульсивных покупок: проверили скорость стриминга, подёргали вLLM или llama.cpp, всё ок — поехали дальше. Оплата — все знакомые способы, включая крипту.

📍 31 страна и 36 ДЦ — близко к пользователю

💾 NVMe + KVM — быстрый запуск моделей

🛡️ Базовая DDoS-защита — спокойствие для API

🧩 Гибкий апгрейд: +ядро/+RAM/+диск

📡 1 IPv4 включён и /64 IPv6

🧪 Тест до 24 часов — измеряйте токены/сек

🕒 SLA 99.9% — предсказуемо и стабильно

💳 Оплата картами, кошельками и криптовалютой

⚙️ Панели ISPmanager/Hestia

💼 Подходит для MVP и пилотов

👉🏻 Перейти на официальный сайт 4vps.su

Timeweb

Timeweb — про гибкость и инфраструктурное спокойствие. Почасовой биллинг позволяет экспериментировать: подняли vLLM, сравнили разные кванты, посчитали стоимость токена — и закрыли, если не зашло. Локации в РФ и за рубежом, под разные рынки и требования по задержкам.

Минимальный вход недорогой, плюс можно докрутить IPv6 бесплатно и не брать лишние опции, пока они не нужны. Хочется DDoS — добавляете за фиксированную плату, авто-бэкапы — считаете отдельно в рублях за гигабайт. Для LLM это удобно: платите за то, чем реально пользуетесь.

API/CLI/Terraform — сказка для тех, кто автоматизирует всё от деплоя до масштабирования. Под такие сценарии удобно держать пайплайны с разными моделями и быстрыми переключениями между конфигами.

⏱️ Почасовой биллинг — идеально для тестов и спайков

🌍 РФ + EU + Казахстан — гибкая география

🧰 API/CLI/Terraform — инфраструктура как код

🔐 DDoS по подписке — включаете, когда нужно

💾 Авто-бэкапы — контроль стоимости за ГБ

📡 IPv6 бесплатно — современная сеть

🧠 Удобно для RAG и A/B-тестов моделей

🕒 SLA 99,98% — почти как метроном

💳 Оплата картами, СБП, ЮMoney, счёт

⚙️ ISPmanager и быстрые развёртки

👉🏻 Перейти на официальный сайт timeweb.com

FirstVDS

FirstVDS — старожил, который умеет в стабильность. Разные линейки (Старт, Форсаж, NVMe, Атлант, Storage) помогают не переплачивать и точно попасть в задачу: от скромного воркера до толстого узла под векторное хранилище и индексы. 1 Гбит/с порт и 32 ТБ трафика в месяц — хватит не только на текст, но и на мультимодальные эксперименты с аудио/картинками.

Один IPv4 включён, IPv6 — по запросу. Поддержка 24/7, привычные способы оплаты, включая безнал для юрлиц. Если у вас LLM выходит в корпоративный периметр — удобно, что есть выбор дата-центров (Москва, Нидерланды, Алматы) и понятная бумажная часть.

Для LLM-проектов я брал бы NVMe-линейку и прикидывал RAM от 8 ГБ на минималку, а лучше 16–32 ГБ для комфортной работы с несколькими воркерами. Дальше — тесты, и уже по факту добавлять ядра и диск.

🏁 Линейки на любой бюджет и нагрузку

💾 NVMe-опции — ускорение инференса

🌍 РФ, ЕС, Казахстан — выбор юрисдикции

📡 Порт до 1 Гбит/с, 32 ТБ трафика

🔌 1 IPv4 включён, IPv6 по запросу

🛎️ Поддержка 24/7 — без ночных драм

💳 Оплата картами, СБП, ЮMoney, безнал

🧱 KVM и честные ресурсы

📦 Storage-тарифы под индексы и эмбеддинги

🧭 Подходит для продакшн-чата и RAG

👉🏻 Перейти на официальный сайт firstvds.ru

AdminVPS

AdminVPS — про понятную цену и спокойствие админа. KVM на NVMe, ежедневные бэкапы, Anti-DDoS и безлимитный трафик на части тарифов — набор, который выручает, если бота внезапно полюбили. Локации — Москва и несколько европейских площадок.

Для LLM это значит: можно собирать приватного ассистента с внешними интеграциями, держать простой RAG и не считать каждый гигабайт. Если нужно, на старших тарифах порт подрастает до 1 Гбит/с, и стриминг ответов работает приятно, без ощутимых ступенек.

Оплаты — какие вам удобно: карты, СБП, кошельки, даже наличные и безнал для юрлиц. Подходит командами, где платёжки — отдельная бюрократия.

💾 NVMe + KVM — честная производительность

🛡️ Anti-DDoS — меньше шансов падений

♾️ Безлимитный трафик на ряде тарифов

🗄️ Ежедневные бэкапы — включили и забыли

🌍 РФ + Европа — гибкая география

📈 Порт до 1 Гбит/с на старших планах

💳 Много способов оплаты, включая безнал

🕑 Поддержка 24/7

🧪 Удобно для прототипов и продакшна

🔧 Лёгкая настройка окружения

👉🏻 Перейти на официальный сайт adminvps.ru

VDSina

VDSina — «честный трудяга» на AMD EPYC. Конфиги понятные, цены ровные, а 32 ТБ трафика в месяц — щедро для задач, где LLM отвечает не только вам, но и клиентам. Порт 1 Гбит/с, KVM, NVMe — классический набор под CPU-инференс квантованных моделей.

Люблю за прозрачность тарифов и опций. Хочется — авто-бэкапы включаются на раз. Нужны дополнительные ресурсы — всё очевидно и без сюрпризов. Платить можно картами, СБП, электронными кошельками и криптой, если так удобнее.

Хороший вариант для сервисов, где важна предсказуемость: несколько воркеров для текстовой модели, сервис эмбеддингов, отдельный процесс под ранжирование (rerankers) — и всё это без ощущения, что сервер «задумался» вместо вас.

🧱 AMD EPYC + KVM — стабильная база

💾 NVMe — быстрый доступ к весам

📡 Порт 1 Гбит/с — хватает на стриминг

📦 32 ТБ трафика (на младшем 1 ТБ)

🧯 Авто-бэкапы — на клике

💳 Оплата картами, СБП, кошельками и криптой

🌍 РФ и Нидерланды — подбирайте локацию

🕒 SLA ~99.9% — надёжно

🛎️ Поддержка 24/7

🔧 Удобен для эмбеддингов и RAG

👉🏻 Перейти на официальный сайт vdsina.ru

Beget

Beget — это про инфраструктурную культуру. Бесплатные авто-бэкапы и SLA 99,98% — слова, после которых спишь лучше. Есть shared-хостинг, VDS и выделенные серверы, так что можно начать скромно и вырасти без миграции в другой стек.

NVMe, KVM и маркетплейс со вспомогательными сервисами — удобно, если вы строите не просто LLM-бота, а маленькую экосистему с базами данных, воркерами и проксями. Поддержка 24/7 и расширенные способы управления: API, CLI, Terraform.

По моему опыту, Beget хорош, когда хочется «делай как у взрослых, только без боли». И это отличный настрой под LLM, где важна не только скорость, но и процесс вокруг.

🛡️ SLA 99,98% — сильная надёжность

💾 NVMe + KVM — шустро и стабильно

🗄️ Бесплатные авто-бэкапы — редкая щедрость

🧰 API/CLI/Terraform — автоматизация без гимнастики

🌍 РФ, Казахстан, Европа

🕒 Поддержка 24/7

🧩 Маркетплейс — быстро собрать окружение

💳 Оплата картами, СБП, ЮMoney, счёт

🧪 Удобно для продакшн-LlM и микросервисов

🔐 Чёткие политики и стабильные ДЦ

👉🏻 Перейти на официальный сайт beget.com

SprintHost

SprintHost — удивляет портом 10 Гбит/с. Даже если ваш бот генерирует ответы на CPU, быстрая сеть делает стриминг почти моментальным, особенно если рядом фронтенд и база. Тарифы стартуют очень бюджетно, что идеально под мини-ассистентов, webhook-обработчики и сервис эмбеддингов.

KVM на NVMe, анти-DDoS, бэкапы — весь базовый джентльменский набор присутствует. Локации — Москва и Санкт-Петербург. Платежи — как вам удобно, включая СБП и электронные кошельки.

Если хочется «попробовать прямо сейчас и не разориться» — это как раз тот тапок, что легко налезает на ногу. А там уже видно, куда масштабироваться.

🚀 Порт 10 Гбит/с — очень быстрая сеть

💸 Тарифы от 91 ₽/мес — вход почти бесплатный

💾 NVMe + KVM — честная производительность

🛡️ Anti-DDoS — базовая защита

🗄️ Авто-бэкапы — без танцев

🌍 ДЦ в Москве и СПб

💳 Оплата картами, СБП, ЮMoney и др.

🕒 Поддержка 24/7

🧪 Хорош для MVP и учебных проектов

🔧 Быстрая настройка

👉🏻 Перейти на официальный сайт sprinthost.ru

FastFox

FastFox — это когда нужен простой старт. Безлимитный трафик, адекватные цены и KVM с NVMe. Для LLM на CPU — спокойно тянет локальные модели 7B-13B в квантованных форматах, а ещё удобно раздавать эмбеддинги и хранить RAG-индексы.

Порт 100 Мбит/с — честный, зато безлимит по трафику. Для небольших команд и личных ассистентов — нормальный выбор. Поддержка на связи, оплатить можно чем удобно, включая безнал для юрлиц.

Сюда я бы ставил сервисы без массивной нагрузки: подсказки, автодополнение, парсинг документов с LLM-экстракцией, лёгкий чат для команды.

♾️ Безлимитный трафик — не думаете о гигах

💾 NVMe + KVM — шустрый диск

💸 Старт от 390 ₽/мес — душевно

🕒 Поддержка 24/7 — всегда кто-то ответит

🔌 Порт 100 Мбит/с — хватит для персональных LLM

💳 Оплата картами, кошельками и для юрлиц

🧠 Хорош для эмбеддингов и лёгких моделей

🧰 Простая админка

🧪 Удобно для прототипирования

🧩 Несколько тарифов под рост

👉🏻 Перейти на официальный сайт fastfox.pro

Fornex

Fornex — зарубежные площадки с добротной репутацией и поддержкой DDoS. Локации в Европе и США подходят, когда важна юрисдикция, близость к зарубежным клиентам или доступ к внешним сервисам с минимальной задержкой. KVM, NVMe и адекватная линейка цен — под типичные CPU-сценарии LLM.

Порт до 100 Мбит/с — это не про бенчмарки скорости, а про ровную работу без скачков. Для бот-API, векторных сервисов и приватных ассистентов — отлично. Платить можно картой и криптовалютой.

Если вам нужно «чтобы там, за рубежом, всё было тихо и надёжно» — это как раз из этой серии. Удобно и без лишних вспышек.

🌍 Германия, Нидерланды, Швейцария, США, Испания

🛡️ DDoS-защита — держит публичные API

💾 KVM + NVMe — ровная производительность

🔌 Порт до 100 Мбит/с — стабильно

💳 Оплата картой и криптовалютой

🕒 Поддержка 24/7

🧠 Подходит для приватных ассистентов

📦 Гибкая сетка тарифов

🔧 Простой старт окружения

🧪 Умеренные цены для долгого использования

👉🏻 Перейти на официальный сайт fornex.com

Как выбрать сервер под LLM без лишних переплат

Я для себя вывел простой фильтр. Если нужен чат-бот, генерация текстов, извлечение данных из документов, эмбеддинги и лёгкий RAG — достаточно VDS на CPU с NVMe и 16–32 ГБ RAM. Берите KVM, чтобы не страдать от «виртуальной совместимости», предпочитайте дата-центры поближе, а модель ставьте в квантованных форматах: GGUF для llama.cpp, GPTQ/AWQ для PyTorch-стека.

Если у вас строгие SLA, много одновременных клиентов и тяжёлая модель (13B и выше без квантования, мультимодальность) — смотрим на выделенный сервер. Там уже логично обсуждать GPU и VRAM, NUMA-политику, большие объёмы RAM и быстрый сторедж. Но в большинстве случаев на CPU можно сделать больше, чем кажется, если грамотно настроить инференс и потоковую отдачу.

🧮 Подберите RAM: 8 ГБ — «на попробовать», 16–32 ГБ — комфорт для 7B–13B

💾 Храните веса на NVMe — экономит секунды при старте

📍 Ставьте ближе к пользователю — задержка решает

🧱 KVM — меньше сюрпризов с совместимостью

🔐 Сразу думайте о DDoS и IP-репутации

🧪 Используйте квантование — падает VRAM/RAM, растёт скорость

Оптимизация производительности: короткий, но рабочий чек-лист

Тайна скорости в мелочах. Включите hugepages, настройте ulimits, зафиксируйте версию ядра и библиотек, отключите прозрачный hugepage, если он мешает предсказуемости, и внимательно отнеситесь к NUMA, если памяти много. Пара кликов в системных настройках нередко даёт +15–30% к стабильной скорости.

Для инференса попробуйте разные движки. llama.cpp невероятно хорош для GGUF, vLLM — для сервинга PyTorch-моделей и параллельной генерации, а text-generation-inference удобен прочной интеграцией и метриками. Стримьте ответы токенами — пользователь чувствует, что «бот думает вслух», и простит даже секунду на прогрев.

🧠 Квантование q4_k_m/q5_0 — лучший друг CPU

🧩 vLLM/llama.cpp/TGI — подберите движок под стек

🧵 Параллельные воркеры + очередь — меньше таймаутов

🔢 Hugepages/THP/ulimits — уберите «просадки»

⚙️ NUMA-aware на больших серверах

📊 Считайте токены/сек и P95 задержку, а не «ощущения»

Бэкапы и мониторинг, которые спасают репутацию

Когда всё хорошо — про бэкапы не думают. А когда «ой» — уже поздно. Делайте snapshots на стороне провайдера там, где это доступно, и параллельно гоните offsite-резерв на другой хост с помощью borgbackup или restic. Конфиги, веса, индексы — храните отдельно и подписывайте версионирование. Лишние 20–40 ГБ в бэкапах дешевле, чем потерянный день.

Мониторинг — минимум Netdata или Prometheus + Grafana, плюс алерты на CPU, RAM, диск, сеть и P95 задержку ответов. Не забудьте проверять репутацию IP и периодически обновлять списки разрешённых доменов/хостов. Для внешней доступности — Uptime Robot или аналог с простыми веб-чеками.

💾 Снимайте snapshots и offsite-бэкапы

🧯 borgbackup/restic — простые и надёжные

📈 Netdata/Prometheus — видно узкие места

⏱️ Алерты на P95/P99 — ловите деградации

🧰 Версионируйте конфиги и веса

🌐 Uptime-чекеры — спокойный сон

Безопасность и стабильность сети: база для публичных API

DDoS — это не страшилка, а статистика. Включайте защиту у провайдера, ограничивайте входящие по IP-спискам там, где можно, ставьте rate limit, а на уровне сервиса — токены и скоупы. Для административной части — SSH по ключам, fail2ban, ограниченные порты и логирование с ротацией. Простые правила, которые экономят нервы.

Фильтрация трафика и репутация IP — особенно важны, если ваш LLM дергает внешние API или шлёт письма. Чистая репутация снижает шанс блокировок. IPv6 — тоже не забывайте: иногда он даёт более стабильный маршрут и меньше сюрпризов с NAT.

🛡️ Anti-DDoS на уровне провайдера

🔑 SSH-ключи, отключение паролей

🚦 Rate limiting и токены на API

👮 fail2ban и аккуратная ротация логов

🧱 Ограничивайте порты и IP-доступ

🌐 Следите за репутацией IP и IPv6

Примеры конфигураций под разные LLM-сценарии

Личный ассистент/чат для команды. 2–4 vCPU, 8–16 ГБ RAM, NVMe 30–60 ГБ. Движок llama.cpp + модель 7B в GGUF q4_k_m. Стриминг ответов через вебсокеты. Отличная скорость и минимальные издержки.

Сервис эмбеддингов и RAG. 4–8 vCPU, 16–32 ГБ RAM, NVMe 100–200 ГБ (под векторные индексы). Модель для эмбеддингов (bge/edict), база Postgres + pgvector. Кеширование частых запросов и батчинг вставок. Локальные ретриверы и фолбэк на внешние.

Публичный API с очередями. 8 vCPU, 32 ГБ RAM, NVMe 100+ ГБ. vLLM/Text Generation Inference. Кластер из воркеров за HA-прокси, rate limit, метрики в Prometheus, алерты на P95. DDoS включен на стороне провайдера.

Немного человеческого: где шутка, а где польза

Я однажды выкатил бота для внутренней команды. Минуты три все молчали, потом кто-то написал «а он живой?» — и ровно в этот момент сервер ушёл в своп. С тех пор я не верю в «потом поставим бэкапы» и «давай возьмём самый маленький тариф, вдруг повезёт». Не везёт. Везёт тем, кто заранее докинул чуть RAM, включил алерты и выбрал провайдера с нормальной сетью. И это не шутка, это страховка вашего времени.

Хороший сервер для LLM — это не про «чтобы запускалось», а про «чтобы радовало». Чтобы бот выдавал мысли, а не крутил спиннер. Чтобы RAG находил нужные факты, а не отрисовывал белый экран. Чтобы платёжка проходила, а IP не шёл в бан. Вот ради этого и нужен аккуратный выбор из топа выше.

FAQ: часто задаваемые вопросы

❓ Нужна ли видеокарта для аренды сервера для LLM?

Не всегда. Если задача — чат-бот, резюмирование, простые RAG и эмбеддинги, то достаточно VDS на CPU с NVMe и 16–32 ГБ RAM, особенно при использовании квантованных моделей (GGUF/GPTQ/AWQ). GPU нужен для больших моделей в нативной точности, мультимодальности и строжайших SLA с высокой одновременной нагрузкой.

❓ Сколько памяти брать под 7B, 13B и 70B на CPU?

Для 7B в GGUF q4_k_m комфортно 8–16 ГБ RAM, для 13B — 16–32 ГБ, для 70B на CPU в продакшн-режиме редко кто идёт — лучше GPU или гибридная архитектура. Всегда допускайте запас под индексы, кеш, очереди и мониторинг.

❓ Что важнее для аренды сервера под LLM: CPU или диск?

Оба. Диск на NVMe ускоряет загрузку весов и индексов, а CPU и его IPC влияют на скорость генерации токенов. Для равномерной работы смотрите на сочетание: 4–8 vCPU, NVMe и RAM от 16 ГБ дают отличную базу.

❓ Как уменьшить задержку ответов LLM на VDS?

Стримьте токены, поставьте сервер ближе к пользователю, используйте квантование и оптимизированные движки (llama.cpp/vLLM/TGI), включите hugepages и настройте очереди воркеров. Следите за P95/P99 в метриках и по факту добавляйте ресурсы.

❓ Какие провайдеры подойдут для дешёвого старта LLM?

Смотрите на 4VPS, SprintHost и FastFox — у них низкий порог входа и NVMe. Для балансировки цены и стабильности — VDSina и FirstVDS. Для гибкости с локациями и тестами — ISHosting и Timeweb. Всё это — удобные варианты аренды сервера для LLM без переплаты.

❓ Как обезопасить публичный LLM-API на арендованном сервере?

Включите DDoS на стороне провайдера, ограничьте доступ по IP где возможно, используйте токены и rate limit, SSH по ключам, fail2ban, ротацию логов и мониторинг P95. Не забывайте про репутацию IP и IPv6-маршруты.

❓ Как настроить бэкапы для LLM и RAG?

Делайте snapshots у провайдера и offsite-копии через borgbackup или restic. Храните веса, индексы и конфиги отдельно, включите версионирование и периодический тест восстановления. Это критично для стабильной аренды сервера для LLM.

❓ Что выбрать: Timeweb с почасовой оплатой или месячный VDS?

Если активно экспериментируете с моделями и нагрузкой — берите почасовой биллинг (Timeweb), так вы заплатите только за фактическое время. Для стабильного продакшна выгоднее месячные тарифы у VDS-провайдеров вроде FirstVDS, VDSina, ISHosting или Beget.

❓ Можно ли уложиться в скромный бюджет?

Да. Начинайте с 2–4 vCPU, 8–16 ГБ RAM, NVMe 30–60 ГБ. Квантованные модели и стриминг токенов превращают даже небольшой VDS в бодрого ассистента. А позже масштабируйтесь по нагрузке — многие провайдеры позволяют увеличивать ресурсы без миграции.

❓ Какие панели и инструменты помогут с LLM на сервере?

ISPmanager, Hestia и DirectAdmin упрощают базовую админку. Для инфраструктуры как кода — Terraform, для мониторинга — Netdata или Prometheus+Grafana, для бэкапов — borgbackup/restic. Так аренда сервера для LLM превращается из «страшной истории» в рутину с приятным результатом.