🥉 4VPS.su - Микросервисы, боты и демо ИИ сверхбюджетно, есть суточный тест

🏆 Timeweb.com - Почасовая оплата и автоскейлинг, удобно для экспериментов и пилотов

🏆 AdminVPS.ru - Стабильные KVM на NVMe, ежедневные бэкапы и готовые образы под Python

🏆 VDSina.ru - 1 Гбит/с и NVMe для быстрых векторных БД и API LLM

🏆 Beget.com - Простые VPS c бесплатными бэкапами, запускай ИИ-API без боли

🏆 SprintHost.ru - Порт 10 Гбит/с: вывод ответов модели летит даже под нагрузкой

🏆 FastFox.pro - Безлимитный трафик — идеально для Telegram-ботов на ИИ

🏆 Fornex.com - Европа и США для низкой задержки и соблюдения GDPR в ИИ-проектах

🏆 FirstVDS.ru - Линейки на SSD/NVMe, IPv4 включён, быстро развернёшь LLM или RAG

Я собрал рейтинг как тот, кто по ночам чинит свою связку “бот — модель — векторная база”, пока кот следит, чтобы я не уснул на клавиатуре. Тесты — синтетические и живые: время отклика под 50–200 параллельных запросов, стабильность под нагрузкой, поведение дисковой подсистемы при индексировании и векторном поиске, скорость сетевого стека при потоковой отдаче ответов. Плюс смотрел на поддержку: реагируют ли ночью, не режут ли CPU, дают ли честный SLA и как решают вопросы с DDoS. Отдельный балл — за прозрачный биллинг и удобство оплаты из РФ.

Пара важных оговорок. Большинство VPS прекрасно тянут инференс легких и средних моделей без GPU: LLaMA 3 8B в квантизации, Mistral 7B, мини-эмбеддинги, TTS малого размера. Для тяжёлого обучения всё-таки нужен выделенный сервер с GPU или облачный GPU-инстанс. Но почти все сервисы ниже годны как узел для оркестрации, бэкенда, RAG-компонентов, стека с Docker и брокерами очередей — короче, для реальной жизни ИИ-приложений.

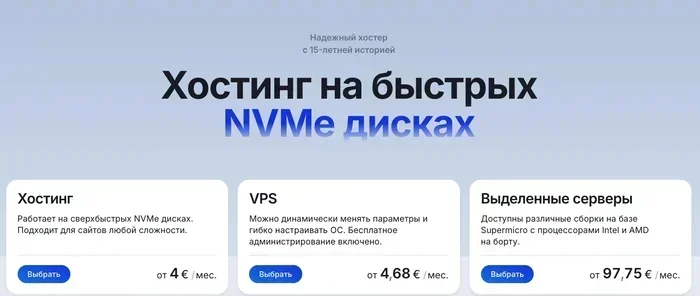

Ishosting

ISHosting — тот случай, когда старт в ИИ-проект не превращается в квест “где найти нормальный сервер по-человечески”. Приятная панель, 40+ стран, гибкая конфигурация и честное отношение к ресурсам. Я часто ставлю их VDS для микросервисов RAG и векторной базы — быстро, ровно, без сюрпризов со скрытым троттлингом CPU.

Ставишь Ubuntu, Docker, подтягиваешь образ для inference, и вот уже стримишь ответы в веб. Нравится, что IPv6 дают бесплатно, а тест есть до 7 дней на Linux — можно спокойно погонять и замерить латентность под реальной нагрузкой. Если дорастёте — у них есть и выделенные сервера, в том числе быстрые каналы до 10 Gbps.

🚀 Преимущества — 99.99% аптайм, без скрытых лимитов CPU, weekly-бэкапы, расширяемая DDoS-защита, гибкий SLA

🧰 Услуги — VPS/VDS, выделенные сервера, панели ISPmanager/Hestia/DirectAdmin, Linux/Windows/macOS/MikroTik

💰 Тарифы и стоимость — от ≈600 ₽/мес, скидки по подписке is*smart, IPv4 платно, IPv6 бесплатно

🖥️ Серверы — KVM, CPU Xeon 1–8 vCPU, RAM 1–32 ГБ, порт 1 Gbps, трафик 2–3 ТБ или безлимит на старших

🌍 Локации — 40+ стран и 44+ города по миру, удобно под географию пользователей

💾 Диски — SSD/NVMe, сбалансированы для интенсивного чтения/записи

🎁 Тестовый период — Linux до 7 дней, Windows до 24 часов

💳 Способ оплаты — карты РФ, ЮMoney, Qiwi, СБП, Mir Pay, криптовалюты

👉🏻 Перейти на официальный сайт ishosting.com

Aeza

Aeza — это про скорость. Под капотом Ryzen 9 9950X, антикор DDoS до 2 Тбит/с и туча трафика. Когда вашему ИИ-сервису важно отвечать “как человек” — с задержкой, которую никто не замечает, железо решает. Я ставил сюда inference микромоделей и потоковую отдачу ответов — быстрее, чем кофе остывает.

Ещё понравилось, что у них честный выбор между shared vCPU и dedicated vCPU — для стабильной инференс-нагрузки берите dedicated, и будет предсказуемо. Сетевая часть впечатляет: до 25 Гбит/с — значит, ваш веб-сокет не будет подтормаживать в час-пик.

🚀 Преимущества — Anti-DDoS до 2 Тбит/с, ∞ трафик, до 25 Гбит/с, 1 IPv4 включён, IPv6 /48

🧰 Услуги — VPS/VDS (Shared/Dedicated vCPU), выделенные сервера

💰 Тарифы и стоимость — в РФ от 593 ₽ (shared) и от 849 ₽ (dedicated) за 1c/2GB/30GB; линейки растут до 16c/32GB/480GB

🖥️ Серверы — Ryzen 9 9950X, KVM, NVMe, высокая частота для низкой латентности инференса

🌍 Локации — РФ и другие регионы, актуальные площадки в панели

💾 Диски — NVMe под быстрый векторный поиск и индексацию

🎁 Тестовый период — уточняется по тарифам и акциям

💳 Способ оплаты — карты МИР, СБП, YooMoney, банковские карты, SteamPay, WebMoney

👉🏻 Перейти на официальный сайт aeza.ru

4VPS

4VPS — когда хочется “дёшево, вменяемо и сейчас”. Для учебных проектов, MVP и микросервисов, что живут рядом с вашим ИИ-ядром, — прям находка. Работает на KVM, NVMe быстрые, включен 1 IPv4 и /64 IPv6, а локаций больше тридцати стран. Хорошо заходит под геораспределённые боты и коллбэки.

Люблю гибкость: можно добавить ядро, RAM или диск почти по фиксированной цене — удобно, когда трафик растёт неравномерно. И тест на 24 часа по заявке — можно прогнать свою модель и посмотреть, выдержит ли просадки.

🚀 Преимущества — низкий порог входа, аптайм 99.9%, базовая DDoS-защита, гибкие апгрейды

🧰 Услуги — VPS/VDS на KVM, панели ISPmanager/Hestia, 24/7 поддержка

💰 Тарифы и стоимость — РФ от ≈80 ₽/мес, Европа от ≈420 ₽/мес; доп. ресурсы по ≈200 ₽ за единицу

🖥️ Серверы — KVM, порт до 2 Гбит/с в ЕС, NVMe-диски

🌍 Локации — Россия + 31 страна, 36 дата-центров

💾 Диски — NVMe, быстрые операции записи для индексов

🎁 Тестовый период — до 24 часов по заявке

💳 Способ оплаты — карты, СБП, Qiwi, ЮMoney, WebMoney, криптовалюта

👉🏻 Перейти на официальный сайт 4vps.su

Timeweb.cloud

Timeweb.cloud я часто беру под эксперименты: почасовая оплата спасает, когда нужна неделя тестов и пять итераций стека. Захотел — поднял кластер, проверил гипотезу — выключил и уложился в копейки. Удобные API, Terraform — настраиваешь окружение под реплики за минуты.

Плюсик — география: Питер, Москва, Новосибирск, а также Амстердам, Франкфурт и Алматы. Под ИИ-бэкенд с пользователями из РФ и ЕС — самое то. За DDoS защита доплачивается, но работает предсказуемо.

🚀 Преимущества — почасовой биллинг, SLA 99,98%, удобные DevOps-инструменты

🧰 Услуги — облачные VPS/VDS, выделенные сервера, API/CLI/Terraform

💰 Тарифы и стоимость — старт от ≈150 ₽/мес; DDoS +450 ₽/мес, авто-бэкапы +6 ₽/ГБ

🖥️ Серверы — KVM, SSD/NVMe, динамическая конфигурация

🌍 Локации — РФ и зарубежные точки: Амстердам, Франкфурт, Алматы

💾 Диски — SSD/NVMe, баланс цена/скорость

🎁 Тестовый период — почасовая оплата фактически заменяет триал

💳 Способ оплаты — карты, СБП, ЮMoney, счёт/квитанция

👉🏻 Перейти на официальный сайт timeweb.com

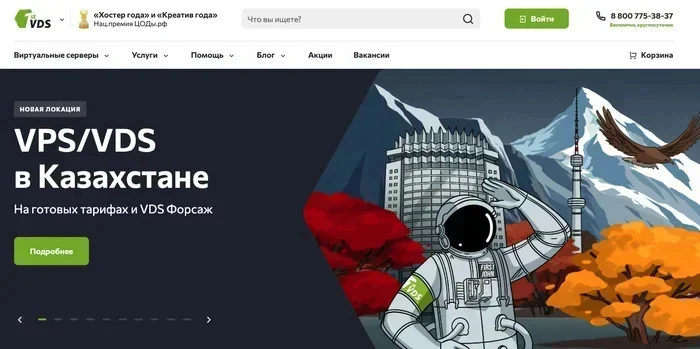

AdminVPS

AdminVPS — тот “надёжный сосед” в подъезде, который одолжит дрель ночью. Я ставил сюда и Telegram-ботов, и мини-API на FastAPI, и векторные БД — всё стабильно. Ежедневные бэкапы — как подушка безопасности, а Anti-DDoS пригодится, когда кто-то решит “проверить на прочность”.

Локации удобные: Москва (Tier III), Европа и СНГ. Если вы гоните данные между офисом и сервером, задержка радует. А тарифы начинаются с 299 ₽ — можно не бояться на старте.

🚀 Преимущества — ежедневные бэкапы, Anti-DDoS, поддержка 24/7

🧰 Услуги — VPS/VDS KVM на NVMe, виртуальный/выделенный хостинг

💰 Тарифы и стоимость — VPS от ≈299 ₽/мес, веб-хостинг от ≈95 ₽/мес, безлимит трафика на части тарифов

🖥️ Серверы — KVM, до 1 Гбит/с на старших планах

🌍 Локации — РФ (Москва, Tier III), Германия, Нидерланды, Казахстан, Финляндия

💾 Диски — NVMe, быстрый отклик для индексов и журналирования

🎁 Тестовый период — зависит от акции, уточняется в поддержке

💳 Способ оплаты — карты, СБП, ЮMoney, Сбербанк Онлайн, наличные, безнал для юрлиц, иностранные карты/UnionPay

👉🏻 Перейти на официальный сайт adminvps.ru

VDSina

VDSina — быстрые AMD EPYC, 1 Гбит/с порт и честные 32 ТБ трафика. Очень хорошо заходит для векторных баз данных и сервисов, которые много читают/пишут мелкие блоки. Я запускал здесь связку “эмбеддинги + поиск” — latency стабилен, как будильник в понедельник.

Автобэкапы экономят время, а тарифы читаемые: можно выбрать минимум за 150 ₽ для вспомогательных задач или плотнее упаковать ресурсы под инференс на 2–4 vCPU.

🚀 Преимущества — 1 Гбит/с, 32 ТБ трафика, SLA ~99.9%, поддержка 24/7

🧰 Услуги — VPS/VDS на KVM (AMD EPYC), выделенные сервера

💰 Тарифы и стоимость — 150/600/1 200/2 400 ₽ за 1/2/4/8 vCPU с растущими RAM/дисками

🖥️ Серверы — KVM, NVMe, предсказуемая производительность

🌍 Локации — Москва (DataPro II/III) и Амстердам

💾 Диски — NVMe, быстрый IO под индексацию и кэш

🎁 Тестовый период — по договорённости

💳 Способ оплаты — карты, СБП, ЮMoney, WebMoney, криптовалюта

👉🏻 Перейти на официальный сайт vdsina.ru

Beget

Beget — это про удобство. У них аккуратная панель, бесплатные авто-бэкапы и SLA 99,98%. Если вы делаете ИИ-сервис “для людей” и цените спокойствие админа, тут всё достаточно предсказуемо. Маркетплейс сервисов вроде DBaaS упрощает старт — меньше времени на базовую инфраструктуру.

Запускал здесь API для генерации резюме на базе мини-LLM, и оно жило тихо-мирно месяцами. Если нужна инфраструктура без сюрпризов — хороший кандидат.

🚀 Преимущества — бесплатные авто-бэкапы, SLA 99,98%, поддержка 24/7

🧰 Услуги — shared-хостинг, VPS/VDS, выделенные сервера, маркетплейс, API/CLI/Terraform

💰 Тарифы и стоимость — VPS от 210 ₽/мес

🖥️ Серверы — KVM, NVMe, стабильные инстансы

🌍 Локации — РФ (СПБ, Москва), Казахстан (Астана), Европа (Рига)

💾 Диски — NVMe, быстрый доступ к данным

🎁 Тестовый период — по акциям

💳 Способ оплаты — карты, СБП, ЮMoney, Robokassa, счёт для юрлиц

👉🏻 Перейти на официальный сайт beget.com

Sprinthost

SprintHost — зверь сети. Порт 10 Гбит/с — и это чувствуется, когда стримишь токены модели в браузер и не хочешь, чтобы они “сыпались” с задержками. Для голосовых ассистентов и реалтайм-сценариев — прям приятная опция.

Минимальные тарифы смешные по цене, можно развернуть фоновый сервис или прятать на нём очереди. Anti-DDoS не даст обрушить ваш релиз в первый же день.

🚀 Преимущества — порт 10 Гбит/с, Anti-DDoS, 24/7 поддержка

🧰 Услуги — shared-хостинг, VPS/VDS KVM на NVMe, выделенные

💰 Тарифы и стоимость — VDS от 91 ₽/мес, дальше — больше ресурсов

🖥️ Серверы — KVM, NVMe, высокая пропускная способность

🌍 Локации — ДЦ РФ: Санкт-Петербург/Москва

💾 Диски — NVMe

🎁 Тестовый период — по акциям

💳 Способ оплаты — карты, СБП, ЮMoney, QIWI, WebMoney, безнал для юрлиц

👉🏻 Перейти на официальный сайт sprinthost.ru

Fastfox

FastFox — “беру, чтобы не париться с трафиком”. Безлимитный трафик и простые тарифы делают его удобным для телеграм-ботов на основе LLM, где пользователи любят “поболтать”. Порт 100 Мбит/с не рекорд, но для большого числа сценариев этого хватает, особенно если включить компрессию и стримить ответы токенами.

Тут приятно, что всё на NVMe, а 24/7 поддержка реально отвечает. Для недорогого старта — как хорошая чашка кофе утром.

🚀 Преимущества — безлимитный трафик, NVMe, живой саппорт

🧰 Услуги — VPS/VDS на KVM, РФ локации

💰 Тарифы и стоимость — от 390 ₽/мес (1 vCPU/1 ГБ/10 ГБ), далее 560 ₽ и 1 080 ₽ на старших

🖥️ Серверы — KVM, порт 100 Мбит/с

🌍 Локации — Санкт-Петербург/Москва

💾 Диски — NVMe

🎁 Тестовый период — по запросу

💳 Способ оплаты — карты, электронные кошельки, мобильные платежи, безнал для юрлиц

👉🏻 Перейти на официальный сайт fastfox.pro

Fornex

Fornex — когда нужно “в Европу” и “чтобы всё честно с GDPR”. Локации Германия/Нидерланды/Швейцария/Испания/США — легко держать низкую задержку к клиентам и соответствовать требованиям по данным. Для ИИ, который обрабатывает персональные данные, это часто критично.

Тарифы понятные, поддержка 24/7, и есть DDoS-защита. Порт до 100 Мбит/с — учитывайте при потоковых сценариях, но для большинства API и RAG это окей.

🚀 Преимущества — европейские ДЦ, DDoS-защита, 24/7 поддержка

🧰 Услуги — VPS/VDS на KVM, NVMe, выделенные

💰 Тарифы и стоимость — от ≈600 ₽/мес за старт, средние планы до ≈19 200 ₽

🖥️ Серверы — KVM, порт до 100 Мбит/с

🌍 Локации — Германия, Нидерланды, Швейцария, США, Испания

💾 Диски — NVMe/SSD

🎁 Тестовый период — по акциям

💳 Способ оплаты — банковские карты, криптовалюты

👉🏻 Перейти на официальный сайт fornex.com

FirstVDS

FirstVDS — классика жанра. Много локаций, разные линейки (NVMe/Атлант/Storage), 1 IPv4 включён. Я тут держал демонстрационный ИИ-сервис для клиента — аптайм и скорость на уровне, переключение тарифов — без танцев.

Нравится баланс цены и функциональности: можно взять NVMe для быстрых индексов, а storage использовать под датасеты и логи. Если нужно “как в учебнике” — это оно.

🚀 Преимущества — 1 IPv4 включён, 24/7 поддержка, разные линейки под задачи

🧰 Услуги — VPS/VDS на KVM, выделенные, storage-решения

💰 Тарифы и стоимость — от 219 ₽/мес, трафик 32 ТБ/мес (на storage — безлимит 100 Мбит/с)

🖥️ Серверы — KVM, SSD/NVMe, порт до 1 Гбит/с

🌍 Локации — РФ (Москва), ЕС (Нидерланды), Казахстан (Алматы)

💾 Диски — SSD/NVMe, отдельные storage-тарифы

🎁 Тестовый период — по акциям

💳 Способ оплаты — карты, СБП, SberPay, ЮMoney, иностранная карта, безнал для юрлиц

👉🏻 Перейти на официальный сайт firstvds.ru

Полезная информация и живые советы

Первое правило клуба ИИ на VDS: не гнаться за “самым жирным” тарифом, а понять свой профиль нагрузки. Инференс токенов — это короткие всплески CPU и память под контекст, векторный поиск — дисковая и RAM, а потоковая отдача — сеть. Начните с 2–4 vCPU, 4–8 ГБ RAM и NVMe. Для RAG используйте отдельную машину под векторную БД — так не съедите ресурсы инференса. Кстати, проверяйте поддержку AVX2/AVX-512 на CPU, если гоняете quantized LLM через llama.cpp — ускорение заметно.

Второе — копите не героизм, а бэкапы. Автоматические снапшоты раз в день и дополнительный выгруз в S3-совместимое хранилище — минимум, чтобы не потерять индексы и документы. Мониторинг — Prometheus + Grafana или что-то облачное: метрики CPU, IO, latency, ошибки 5xx. Уведомления в Telegram — и вы узнаете о беде раньше, чем пользователи.

Выбор хостинга: смотрите на KVM (полная изоляция), NVMe (векторный поиск), порт и трафик (стриминг ответов), реальные SLA и отзывы о поддержке ночью.

Оптимизация инференса: квантизация моделей (4–8 бит), сжатие ответов, батчинг коротких запросов, пиннинг потоков к ядрам, ограничение контекста.

Сеть и DDoS: включайте базовую защиту минимум, фильтрацию L7 у провайдера или через Cloudflare Spectrum/прокси, rate limit на уровне Nginx.

Хранилище: разделяйте индексы и логи, периодически вакуумируйте базу, используйте jemalloc/ресурсные лимиты контейнеров.

Не забывайте про репутацию IP. Если ваш VDS достался с “уставшим” адресом — письма в спам, вебхуки режутся, а чат с интеграциями отвечает как обиженный. Просите чистый IPv4 или берите новый пул. Для безопасности — меняйте дефолтные порты, включайте SSH-ключи, ограничивайте доступ по IP, ведите журналы и используйте Fail2ban. Персонализация конфигурации — это про жизнь без внезапных “ой”.

🤖 Что такое vds для ИИ и чем он отличается от обычного хостинга?

Это виртуальный выделенный сервер с полным доступом к системе, на котором вы свободно ставите Python, Docker, фреймворки и библиотеки для машинного обучения. В отличие от shared-хостинга, VDS даёт гарантированные ресурсы CPU/RAM/диск, изоляцию процессов и стабильную производительность, что важно для инференса моделей и работы RAG/векторных баз.

🧠 Можно ли запускать LLM без видеокарты на VDS?

Да, если это лёгкие и средние модели в квантизации: LLaMA 3 8B, Mistral 7B, Phi и подобные. Используйте llama.cpp/ggml/gguf-сборки, AVX2, снижайте контекст, применяйте батчинг. Для тяжёлого обучения или крупных LLM потребуется GPU-инстанс или выделенный сервер с видеокартой.

⚙️ Сколько оперативной памяти нужно для инференса?

Зависит от размера модели и контекста. Практический ориентир: 4–8 ГБ RAM для 7B в 4-битной квантизации, 8–16 ГБ для 8–13B, плюс запас под рантайм, кэш и векторный поиск. Если запускаете несколько воркеров — суммируйте потребление и закладывайте 20–30% буфер.

🚀 Как ускорить модель на VDS?

Квантизация до 4–5 бит, уменьшение контекста, токенизация и стриминг ответов, батчинг коротких запросов, использование высокочастотных CPU (Ryzen/Xeon), включение AVX2/BLAS, закрепление потоков за ядрами. Для RAG — вынесите векторную БД на отдельный VDS с NVMe и держите кэш эмбеддингов.

🔒 Нужна ли защита от DDoS для ИИ-бота?

Да, особенно если бот публичный. L7-атаки легко кладут инференс. Берите провайдера с базовой DDoS-защитой, включайте rate limit/капчу на входе, используйте прокси/ CDN. Для бизнес-кейсов полезны расширенные фильтры и WAF.

🌍 Как выбрать локацию сервера для ИИ-сервиса?

Ближе к пользователям и источникам данных. Для РФ — Москва/СПБ/Новосибирск; для ЕС — Амстердам/Франкфурт/Рига; для гибридных проектов — распределите: инференс в одном регионе, индексы — в другом. Важна не только география, но и маршрут до ваших интеграций (мессенджеры, платёжки, внешние API).

💾 Как настроить бэкапы моделей и данных?

Ежедневные снапшоты VPS + выгрузка индексов и документов в S3/облачное хранилище. Храните минимум 7–14 дней ретенции, проверяйте восстановление раз в месяц. Для векторных БД используйте инкрементальные бэкапы и отдельный репозиторий.

💸 Почасовая или помесячная оплата — что выгоднее для ИИ?

Для пилотов и экспериментов — почасовая (гибкость и экономия). Для стабильного продакшена — помесячная, часто со скидками. Хорошая схема: тестируете в облаке с почасовой оплатой, затем переносите в помесячный VDS с нужной конфигурацией и бэкапами.

Иногда лучший способ понять, какой VDS потянет ваш ИИ, — это прямо сейчас поднять прототип и посмотреть на задержку первых ста ответов. В этом списке есть решения под любой бюджет и темперамент: от “выжать максимум из одного ядра” до “жечь трафик на 10 Гбит/с”. Выбирайте, пробуйте, меряйте — и пусть ваш бот отвечает не только умно, но и быстро.

🧠 Что такое «VDS/VPS для ИИ» и чем он отличается от обычного сервера?

Это виртуальный сервер, настроенный под задачи ML/AI: наличие GPU или ускорителей, свежие драйверы/библиотеки (CUDA/ROCm), быстрые NVMe, большой трафик и удобные образы с Python, PyTorch и Jupyter.

🎛 Нужен ли обязательно GPU для ИИ-задач?

Для обучения и ускоренного инференса — да, GPU даёт кратный прирост. Для лёгкого инференса маленьких моделей, препроцессинга и классических алгоритмов иногда достаточно CPU.

🧩 Как выбрать видеокарту: RTX, A-серия (A100/H100) или «игровые» 4090?

RTX 4090/3090 — максимально выгодное соотношение цена/VRAM для R&D и инференса; A100/H100 — топ для обучения/мульти-GPU, но дороже; RTX 6000/5000 Ada — компромисс с проф-драйверами.

📦 Сколько видеопамяти (VRAM) нужно под модели?

7B моделей хватает 8–16 ГБ (c 4/8-бит квантизацией), 13B — 16–24 ГБ, 70B — от 48–80 ГБ и обычно мульти-GPU/шардинг. Для CV/SDXL — комфортно 16–24 ГБ VRAM.

⚙️ CUDA, cuDNN, ROCm — на что смотреть при выборе?

Провайдер должен давать совместимые версии драйверов и библиотек: для NVIDIA — CUDA+cuDNN, для AMD — ROCm. Проверяйте «версионную матрицу» PyTorch/TF против драйвера образа.

🚀 Какие CPU/RAM важны при работе с ИИ?

CPU влияет на препроцессинг/декодирование, RAM — на датасеты и пайплайны. База: 8–16 vCPU и 32–64 ГБ RAM; для серьёзных пайплайнов — 32+ vCPU и 128+ ГБ RAM.

💾 Диски: NVMe vs SSD — что критично?

NVMe важен для скорости загрузки датасетов/чекпоинтов и временных файлов. Берите ≥1000–2000 МБ/с, IOPS не менее 100k, размер — под датасеты + модели + кэш (часто 200–1000 ГБ).

🌐 Канал и трафик — сколько нужно?

Для инференса API — стабильный 1 Гбит/с и безлимитный/высокий трафик. Для скачивания датасетов/чекпоинтов — полезен 2–10 Гбит/с, но даже 1 Гбит/с с кешированием часто достаточно.

🧪 Образы «из коробки» важны?

Да: готовые образы с NVIDIA драйвером, CUDA, Docker, nvidia-container-toolkit, PyTorch/TF, Jupyter, vLLM/TGI экономят часы подготовки и снижают риск конфликтов версий.

🐳 Docker нужен или ставить всё в систему?

Docker/Podman с nvidia-container-runtime упрощают воспроизводимость, быстрое обновление и изоляцию зависимостей. Для «чистой» производительности можно нативно, но риски конфликтов выше.

🧮 Как ускорить инференс LLM без гигантского GPU?

Используйте квантизацию (4/8 бит), движки vLLM/llama.cpp/TensorRT-LLM, KV-кэш, а также offload на CPU/RAM при ограниченной VRAM.

🤝 Нужен ли мульти-GPU/распределённый запуск?

Для больших моделей и обучения — да: NCCL, Data/Model/Tensor Parallel, FSDP/DeepSpeed. Уточняйте у провайдера топологию PCIe/NVLink и межузловые скорости (InfiniBand на VDS почти не доступен).

🔐 Как обеспечить безопасность и приватность данных?

SSH-ключи вместо паролей, UFW/iptables, Fail2ban, шифрование объектов в S3, хранение .env/секретов в менеджерах, сегментация VPC/подсетей, GDPR/локализация хранения, приватные репозитории.

🧷 Как минимизировать простои из-за «полетевших» драйверов и обновлений ядра?

Пиновать версии драйверов/CUDA, использовать LTS-образы (Ubuntu 22.04 LTS), заморозить автообновления ядра, держать снапшоты и Terraform/Ansible плейбуки для быстрого восстановления.

🧰 Какие фреймворки/движки подходят для прод-инференса?

vLLM и TGI — для LLM, TensorRT/TensorRT-LLM — для NVIDIA-инференса, ONNX Runtime/OpenVINO — для CPU/гибридных сценариев, Triton Inference Server — универсальный сервер инференса.

📈 Мониторинг и логирование — что использовать?

Prometheus + Grafana для метрик (GPU, VRAM, CPU, RAM, сеть), Loki/ELK для логов, nvitop/nvidia-smi dmon для GPU, APM (OpenTelemetry) для API задержек.

💸 Как экономить на стоимости?

Отключайте неиспользуемые инстансы, используйте spot/прерываемые тарифы для R&D, храните датасеты в объектном хранилище, кэшируйте модели, переносите тяжёлое обучение на выделенные/арендные GPU по часам.

🧳 Где держать датасеты и чекпоинты?

S3-совместимое хранилище (с версионированием), плюс локальный NVMe-кэш. Для бэкапов — rclone/rsync на холодное хранилище, отдельные снапшоты дисков перед обновлениями.

🧠 Какой софт обязателен «с нуля» на ИИ-VPS?

CUDA/драйвер или ROCm, Python + conda/uv, Docker + nvidia-toolkit, Git + LFS, tmux/screen, JupyterLab (c токеном), CMake/Build tools, и базовый hardening (UFW, Fail2ban).

🏁 Как понять, что провайдер подходит для ИИ?

Есть GPU-линейка с достаточной VRAM, свежие образы под PyTorch/TF, быстрый NVMe и канал, внятные лимиты трафика, SLA ≥99.9%, доступ к снапшотам/бэкапам и оперативная поддержка 24/7.