Stable Diffusion & Flux

Планировщик задач для Automatic1111 или Vlad

Можно поставить как через расширение в web-ui так и с гитхаба.

* Повторяющиеся задачи можно добавлять в закладки

* менять промты и модели на лету

* менять местами таски, отменять их, и мониторить историю

* работать через API

* и не только

Установка:

- Открываем "Extensions"

- "Install from URL".

- Вставляем URL репозитория: https://github.com/ArtVentureX/sd-webui-agent-scheduler.git

- Жмём "Install"

- Открываем вкладку "Installed"

- Нажимаем "Apply and restart UI".

Обзор и сравнение 5 редакторов поз для ControlNet

Во всех руководствах по установке ControlNet была рекомендация использовать posex для работы с позами. Спустя несколько месяцев появилось более мощные редакторы, posex морально устарел и перестал обновляться, а в последних версиях WebUI он просто перестал работать. Пришло время искать замену.

В этой заметке я расскажу о 5 редакторах поз, которые рекомендую использовать вместо posex.

SD WebUI OpenPose Editor

Ссылка для установки расширения: https://github.com/huchenlei/sd-webui-openpose-editor

Самый мощный из доступных редакторов поз для ControlNet. Кроме стандартного скелета передаёт для рисования информацию о пальцах и положении лица в пространстве.

Особенности редактора

Работает внутри ControlNet, но доступ к редактору не тривиален

— Загружаем изображение-референс в ControlNet v1.1.217 (или новее), модель поз должна быть версии 1.1 или выше

— Выбираем “Enable” и “Allow Preview”, в категории “Control Type” выбираем “OpenPose”

— Жмём кнопку с непонятной иконкой, которая находится между “Preprocessor” и “Model”

— В появившемся блоке “Preprocessor Preview” жмём “Edit” и попадаем в редактор

— Кнопка “ui.sendPose” в левом верхнем углу редактора отправляет позу в ControlNetРабота со скелетом в плоскости

Возможность перетаскивать ноды мышкой или задавать численные координаты

Автоматически распознаёт позу и добавляет скелет с учётом положения кистей рук и лица. Дополнительные скелеты можно добавить вручную.

Возможен импорт позы из JSON

Редактирование позы либо мышкой (перетаскиваем ноды), либо изменением координат в специальном интерфейсе

Импорт/экспорт позы в JSON, с сохранением возможности редактировать

Экспорт позы в png, без возможности редактирования

Отсутствует вращение камеры (может быть минусом), возможно приближение/отдаление курсором мыши

Установка расширения состоит из нескольких этапов:

Обновление ControlNet до v1.1.217 или более свежей

Установка расширения стандартным способом через вкладку “Extensions” в WebUI (инструкция в конце поста)

Необходимо скачать архив dist.zip из репозитория проекта

https://github.com/huchenlei/sd-webui-openpose-editor/releases

и распаковать в папку с заменой файлов

stable-diffusion-webui\extensions\sd-webui-openpose-editor\dist

Openpose Editor

Ссылка для установки расширения: https://github.com/fkunn1326/openpose-editor

Openpose Editor — это продвинутый, в сравнении с posex, редактор поз для ControlNet. Но в сравнении с другими это достаточно простой редактор.

Особенности редактора

Работа со скелетом в плоскости

Автоматически определяет позу из добавленного изображения (Detect Image)

Ручная настройка, или редактирование, позы по фоновому изображению

Сохранение созданной позы в качестве пресета

(поза добавляется в конфиг \extensions\openpose-editor\presets.json)Импорт/экспорт позы в JSON, с сохранением возможности редактировать

Экспорт позы в png, без возможности редактирования

Отправка готовой позы в ControlNet одним кликом

Возможность разместить сколько угодно скелетов

Отсутствие вращения камеры (может быть минусом), размер скелета изменяется растягиванием объекта

Depth Library

Ссылка для установки расширения: https://github.com/jexom/sd-webui-depth-lib

Depth Library — это не полноценный редактор поз, а дополнение к любому другому редактору, которое необходимо для улучшения рисования кистей рук. Стандартную библиотеку пресетов можно дополнить любым количеством кистей, в сообществе на civitai выложено несколько подборок (900 штук, 50 штук).

Принцип работы редактора: вы добавляете кисти рук с необходимым вами расположением пальцев в пространстве, и на основе этого генерируете маску глубины (depth mask). При рисовании персонажа через ControlNet в одном юните вы задаёте скелет (open pose), во втором карты глубины (depth) из этого расширения и если всё сделано правильно — у вас получатся идеальные руки.

Особенности расширения

Все настройки, включая положение кистей в пространстве и их размеры необходимо задавать вручную, для лучшего результата в два этапа: сначала по референсу выставляем размер кистей, затем по скелету для этого референса выставляем кисти в нужные места.

Возможности расширения напрямую зависят от количества добавленных вариантов кистей. При желании можно добавлять кисти самостоятельно.

Отправка полученной маски в ControlNet одним кликом

Экспорт масок в png

3D OpenPose Editor

Ссылка для установки расширения: https://github.com/nonnonstop/sd-webui-3d-open-pose-editor

Браузерная версия, работает без установки https://zhuyu1997.github.io/open-pose-editor/

Мощный редактор поз с возможностью работы со скелетом в пространстве, что позволит точнее настроить позу.

Помимо стандартного скелета openpose, расширение генерирует контуры, маску глубину и карту нормалей для кистей рук и стоп. Для достижения наилучших результатов стоит использовать комбинацию скелета и контуров/маски/карты (одно из трёх). Выбирать пару стоит исходя из вашего референса. Для простых достаточно скелета и контуров или скелета и маски. В сложных случаях рисование по скелету и карте нормалей покажет наилучший результат.

Можно рискнуть и рисовать по четырём файлам. Но с большой долей вероятности результат будет хуже, чем при рисовании по двум.

Особенности редактора

Работа со скелетом в объёмном пространстве, возможность точнее задавать позу и положение конечностей

Возможность настройки пальцев на кистях рук и положения стоп

Автоматическое распознание позы работает, но не идеально (пример на скрине), можно вручную задать позу по фоновому изображению

Помимо скелета openpose генерирует контуры (canny), маску глубины (depth) и карту нормалей (normal) для кистей и стоп

За это отвечает фиолетовая кнопка “Generate” в правом верхнем углу редактора.Экспорт результатов в png

Отправка скелета и масок в ControlNet одним кликом

С непривычки работать в редакторе очень неудобно

PoseMy.art

Внешний сайт: https://app.posemy.art/

Условно-бесплатный браузерный редактор поз с самыми большими, на данный момент, возможностями по настройке позы. Все необходимые для работы функции доступны в базовой версии, за пейволлом лишь необязательные.

Особенности редактора

Работа со скелетом в объёмном пространстве, возможность точнее задавать позу и положение конечностей

Возможность настройки пальцев на кистях рук и положения стоп

Коллекция пресетов поз и сцен (в платной версии их больше)

Анимация скелета (2446 штук), возможность остановить движение и экспортировать скелет по стоп-кадру

Выставление объектов (пропсов) на сцену: в бесплатной версии ограничение только из стандартного набора; в платной версии импорт любых

Три варианта экспорта в png: скелеты без пальцев и с пальцами + карта нормалей всей сцены (улучшит результаты при рисовании сцены с объектами)

Экспорт сцены как картинки

Нет быстрой отправки в ControlNet

Распознание позы по изображению доступно в платной версии

Как установить расширения?

Для установки расширений необходимо перейти во вкладку Extensions вашего Web UI

Вкладка Install from URL

Вставляем в поле ссылку на репозиторий проекта, например https://github.com/huchenlei/sd-webui-openpose-editor

Жмём Install и ждём пока не появится сообщение об успешной установке (подчёркнуто красным)

Переходим во вкладку Installed

Жмём Apply and restart UI и ждём перезапуска сервера

Сравнение расширений

Из пяти редакторов в подборке четыре самостоятельные и один вспомогательный (Depth Library). В идеальном мире стоило бы выбрать один основной редактор и пользоваться только им, но это будет непросто.

Если вы создаёте позы по референсам, то sd-webui-openpose-editor будет лучшим выбором, а связка Openpose Editor + Depth Library отстанет с небольшим отрывом. Остальные редакторы менее удобны в этой задаче.

Но если вы создаёте позу с нуля, без референсов, или нужно задать сложный угол камеры – редакторы 3D OpenPose и PoseMy.art окажутся наилучшим выбором.

Четыре редактора из пяти умеют рисовать пальцы. Но если объект съёмки находится на удалении от камеры кисти будут закручены в причудливые загогулины, несмотря на настройки редактора.

Для себя приоритет при выборе редакторов вижу так:

sd-webui-openpose-editor когда персонаж находится близко к камере и кисти рук не перекрывают скелет

Openpose Editor когда персонаж отдалён от камеры или кисти рук перекрывают скелет. Обязательно попробую нарисовать с Depth Library и без неё.

PoseMy.art или 3D OpenPose когда потребуется что-то этакое или захочу задать необычный угол камеры. Но таких задач пока не было, обычно все углы и ракурсы задаю токенами.

В комментариях с удовольствием отвечу на вопросы, связанные с использованием этих редакторов поз.

______________________________

Буду рад видеть вас в телеграм-канале, где в таком же формате рассказываю о полезных малоизвестных расширениях и инструментах, показываю примеры использования интересных токенов и делюсь красивыми моделями, на которых рисую сам.

DiabloSet StableDiffusion

В честь выхода Diablo IV решил немного нагенерить нагнать жути

Так же буду рад вас видеть в своем телеграм канале, где я выкладываю свои нейро-арты, делюсь промптами, фотографиями и рассказываю про обработку:

https://t.me/artemphotography

QR-коды, пропущенные через нейросеть1

Когда увидел на Реддите - сперва подумал, что это просто картинки по мотивам QR-кодов, этакие стилизации, но в комментариях я узнал, что все они работают. Я, конечно, всё равно не поверил, достал телефон и... Таки да! Благодаря высокой надежности QR-кодов и избыточному резервированию, они выдерживают такое издевательство. На некоторые, правда, приходится целиться подольше. Возможно, в будущем это станет нормой.

Обнимашки

Здесь можно найти полное качество и поддержать финансово, если нравится мое творчество.

Tribe Navajo

Еще больше работ можно найти в моем телеграмм канале,там я публикую каждый день свои работы https://t.me/neirosea

Оставляй комментарий как тебе мои работы

промт=

a beautiful Navajo woman, dressed in Navajo clothing, around a tribal wigwam settlement,(wast view:1.4), (1woman:1.5), 25 yo kelly character,(russian roots:1.5), black hair, masterpiece, top quality, best quality, official art,(hyperdetailed:1.15), (soft light, sharp:1.2), ultra detailed texture, ultra detailed eyes, (photorealistic, illustration, uhd, unreal engine, sharp focus,)

Negative prompt: cartoon,2girls,2woman, anime, sketches,nude,nsfw, loli,yong girl,girl, (worst quality:2), duplicate, (low quality:2), (normal quality:2),text,word,username,watermark,logo, lowres, normal quality, ((monochrome)), ((grayscale)), skin spots, acnes, skin blemishes, bad anatomy, girl, loli, young, large breasts, red eyes, muscular, over saturated, over saturated, over saturated

Steps: 100, Sampler: DPM++ 2M Karras, CFG scale: 7, Seed: 3700841157, Size: 768x1024, Model hash: eb55ac06c2, Model: NewDreamV8-fp16-no-ema, Denoising strength: 0.45, SD upscale overlap: 64, SD upscale upscaler: 4x-UltraSharp

Все что нужно знать про модели stable diffusion. Часть 1

Что такое модель?

Модель - это файл в котором хранятся параметры нейросети и именно модель является самым важным элементом в генерации картинок. Поэтому если у нас нет модели, то и сгенерировать мы ничего не сможем.

С чего все начиналось

Сама собой модель не появиться, поэтому мы должны ее сделать и натренировать. Для тренировки нам нужен так называемый "датасет" - набор данных на которых нейросеть будет учиться и куча видеокарт, которые это все будут обрабатывать. Потратив кучу времени и денег, на выходе мы получим нашу модель. Именно таким образом и создавались основные модели stable diffusion - первой и второй версии.

Модели версии 1.x и 2.x

1.x

Самая первая модель создавалась с нуля (неожиданно!): взяли кучу картинок, подрубили видяхи и натренировали. Для следующей модели - версии 1.2 - взяли первую модель и продолжили ее тренировать, в итоге получив новую. С остальными точно также: 1.3 это продолжение 1.2, 1.4 - продолжение 1.3, 1.5 - продолжение 1.4. Из этой линейки моделей, в силу качества получаемых картинок, лучше всего себя зарекомендовали версии 1.4 и 1.5. Сейчас, например, версия 1.5 это стандарт для тренировки разных дополнительных мелких моделей (экстрасетей типа лор, текстуальных инверсий, гиперсетей или создания своей модели). Также с версии 1.2 была выучена еще одна модель - 1.5 inpainting, предназначение которой (неожиданно! x2) inpaint и outpaint (перерисовка части картинки или дорисовка вне ее). Вот как выглядит линейка первой версии

1.5-inpainting вставить было некуда, но она есть

Ссылки на версии 1.1-1.3 больше для целостности списка, а 1.4, 1.5 и 1.5-inpainting можете добавить в закладки

v1.1: https://huggingface.co/CompVis/stable-diffusion-v-1-1-original

v1.2: https://huggingface.co/CompVis/stable-diffusion-v-1-2-original

v1.3: https://huggingface.co/CompVis/stable-diffusion-v-1-3-original

v1.4: https://huggingface.co/CompVis/stable-diffusion-v-1-4-original

v1.5: https://huggingface.co/runwayml/stable-diffusion-v1-5

v1.5-inpainting: https://huggingface.co/runwayml/stable-diffusion-inpainting

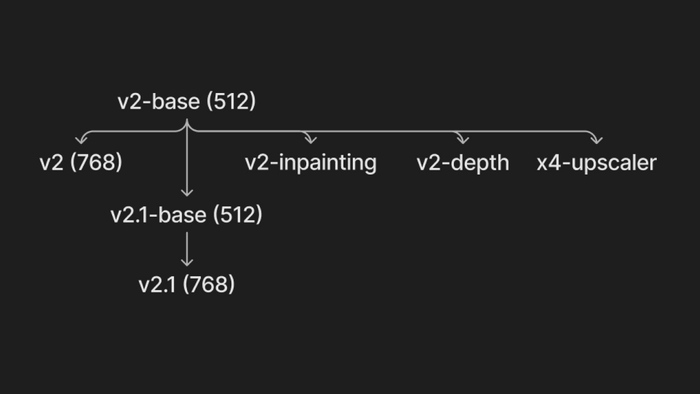

2.x

Линейка моделей второй версии не стала продолжением первой, как можно было предположить, а была создана с чистого листа. Цепочка следующая: сначала сделали базовую модель "2-base" и от нее сделали пачку других. Потом натренировали 2.1-base, основываясь на 2-base, и уже от новой (т.е. 2.1-base) сделали еще одну. Проще картинкой (512 и 768 - это разрешения)

2-base: https://huggingface.co/stabilityai/stable-diffusion-2-base

2-inpainting: https://huggingface.co/stabilityai/stable-diffusion-2-inpainting

2-depth: https://huggingface.co/stabilityai/stable-diffusion-2-depth

4x-upscaler: https://huggingface.co/stabilityai/stable-diffusion-x4-upscaler

2 (768): https://huggingface.co/stabilityai/stable-diffusion-2

2.1-base: https://huggingface.co/stabilityai/stable-diffusion-2-1-base

2.1: https://huggingface.co/stabilityai/stable-diffusion-2-1

А разница есть?

Да.

Обе линейки тренировались по разному (датасет, разрешение, количество шагов). Насколько я знаю, для второй линейки датасет фильтровали более консервативно: там получилось меньше nsfw, меньше качественных фото, меньше крутых артов и тд. Если интересно, то тут можете глянуть примеры того что не вошло (порнуха даже при значении фильтра в 0.99 не всегда попадается, а они ограничились 0.1...) К тому же, во второй версии используется другая модель для обработки текста, которая тренировалась тоже по другому и данном случае это получилось хуже чем было. Еще, в силу разных архитектур моделей, все что комьюнити наработало для версии 1.x не совместимо с версией 2.x. Итог подвести можно мемом

Я совсем немного работал со второй версией, поэтому если вам есть что рассказать - прошу в комментарии, с удовольствием почитаю.

Кто хочет подробнее ознакомиться с параметрами обучения этих моделей, прошу:

https://huggingface.co/stabilityai/stable-diffusion-2#training

https://huggingface.co/runwayml/stable-diffusion-v1-5#training

Хорошо, я понял и какую мне выбрать?

Никакую. В силу того, что это базовые модели, они могут нарисовать почти все, но это "все" они нарисуют посредственно. Но мы можем взять их за основу и немного дотренировать в нужную сторону, будь то аниме или фотореализм.

Вот например модель дотренированная специально для всякой фантастики (rpg). Эту тренировали на куче артов, чтобы получалось красиво. А для аниме натренировали эту, можно еще nai вспомнить (nai - модель компании NovelAI, которую слили в сеть и используют все кто хочет)

Тактично промолчу про кучу натренированных моделей для генерации порнухи.

- сгенерирую пару артов; - ты же не будешь делать девченок с огромными сиськами... да?

Небольшое отступление. Как мне кажется, в комьюнити есть небольшая непонятка с "тренировкой". Этим словом обозначают все: и тренировку используя 100 фоток для себя и дорогостоящую тренирову основных моделей. То, что я описывал до этого - это прям тренировка, то есть миллионы фотокарточек, сотни тысяч шагов и тысячи часов работы видеокарт. Для сравнения:

stable-diffusion 1.1 тренировалась на 170 миллионах картинок

NovelAI использовали 5.3 миллиона картинок

waifu-diffusion 1.3 тренировалась на 680 тысячах картинок

Это я для понимания разницы, потому что когда мы тренируем на 100 картинках и когда парни впрягаются и берут тысячи картинок - и то, и то тренировка, но надеюсь вы понимаете что это сильно разные "тренировки" и подход немного разный.

Миксы

Продолжим. Как я писал выше, тренировать - это долго, дорого и еще надо постараться чтобы получилось хорошо. А на это не у всех есть время, деньги и необходимые знания/сотрудники. Но если у нас есть несколько натренированных моделей, то почему бы нам не попробовать их смешать между собой в некоторой пропорции? Именно так и делают миксы/мержы: берут модели которые понравились и смешивают их вместе до результата, который понравиться. И смешивать так можно любое количество моделей. То как их правильно мержить это отдельное искусство.

Большинство моделей это именно миксы: кто-то не стесняется и пишет прям в названии "Mix" как например GhostMix, кто-то щедро расписывает в описании что с чем мешал, как делает Protogen или Art&Eros, а кто-то и в названии пишет и подробнее расписывать не лениться - OrangeMix. Но большинство, к сожалению, просто выкладывает модель. В лучшем случае напишет пару промптов и настройки для примера. Что там человек намешал? В каком соотношении? Доучивал еще сам или только сделал микс? Хуй. Его. Знает.

Ответы на эти вопросы важны, потому что если микс основан на модели от nai например, то мы можем спокойно использовать дефолтный nai'вский промпт (с доработкой в сторону других моделей в мерже), тоже самое и с каким-нибудь f222 или другими моделями для людей, чтобы целенаправленно писать mutated, disfigured, а не просто лить в промпт все подряд или тупо копировать из картинки с civitai. Аналогично дело обстоит и c остальными параметрами типа clip-skip. Тот кто учил, обычно знает особенности своей модели, тот кто смешивал - ?

Короче, миксы - дешево, сердито, но можно делать очень круто, при нулевых затратах на датасет и тренировку.

Хочу, хочу, хочу

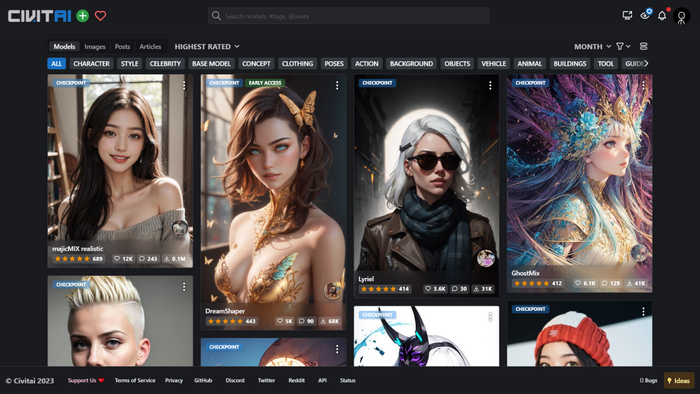

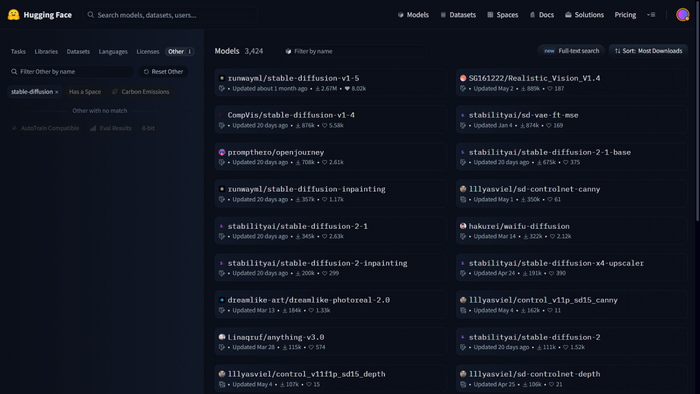

Где же брать, эти ваши модели? Основных ресурса два:

civitai

Дружелюбный интерфейс, много различных моделей, в том числе и nsfw. Помимо моделей там лежит еще куча всего: лоры, ембеддинги, позы для controlnet, гайды всякие.

huggingface

Более техническая/официозная платформа, тут лежат основные модели sd, остальные заливают по желанию. Но там также лежат модели для controlnet и в целом, можно найти много полезного

Повторение - мать учения

Модель - файл, который отвечает за генерацию картинок, без него ничего работать не будет.

Модели можно создать двумя способами:

тренировка (берем картинки, видеокарты и вперед)

микс (смешивание нескольких готовых моделей)

Есть основные/официальные модели двух версий. Они могут все, но это все делают средне.

Есть куча пользовательских моделей, которые уже заточены под конкретные стили/направления. По большей части это миксы. Качаем на civitai и huggingface и читаем описание моделей, там как минимум можно увидеть настройки, которые рекомендует автор.

Если вы пользуетесь автоматиком (инструкция по установке) файлы с моделями класть в папку stable-diffusion-webui\models\Stable-diffusion

Что будет дальше

Вообще хотел написать про расширения (всякие ckpt и safetensors), ema и fp, что они значат и какую модель брать, но решил сначала обговорить базу, чтобы дальше было проще. Это все обсудим во второй части.

Нейронки интересная и непростая штука, поэтому если хотите лучше в них разобраться, подписывайтесь на канал, там рассказываю как работать с SD